–ö–Ψ–≥–Α―²–Ψ –€–Α–Ι–Κ―Ä–Ψ―¹–Ψ―³―² –Ω―É―¹–Ϋ–Α ―¹–≤–Ψ―è –Η–Ζ–Κ―É―¹―²–≤–Β–Ϋ –Η–Ϋ―²–Β–Μ–Β–Κ―² - ―΅–Α―² –±–Ψ―², –Ϋ–Α―Ä–Β―΅–Β–Ϋ –Δ–Α–Ι (―¹―ä–Ζ–¥–Α–¥–Β–Ϋ ―¹ ―Ü–Β–Μ –Β –¥–Α –Ω―Ä–Ψ–≤–Β–Ε–¥–Α –Ζ–Α–±–Α–≤–Ϋ–Η ―΅–Α―²–Ψ–≤–Β –Η –¥–Α ―¹–Β ―É―΅–Η –Ψ―² ―Ä–Α–Ζ–≥–Ψ–≤–Ψ―Ä–Η―²–Β ―¹–Η ―¹ –Ω–Ψ―²―Ä–Β–±–Η―²–Β–Μ–Η―²–Β), –Ω―Ä–Β–¥–Η –Β–¥–Ϋ–Α –≥–Ψ–¥–Η–Ϋ–Α –≤¬†Twitter, –Ϋ–Β―â–Α―²–Α –Ω–Ψ–Β―Ö–Α –Κ―ä–Φ –Ω―Ä–Β–¥–Η–Ζ–≤–Β―¹―²–Β–Ϋ –Κ―Ä–Α―Ö. –Γ–Α–Φ–Ψ –Ζ–Α 24 ―΅–Α―¹–Α ―Ä–Ψ–±–Ψ―²―ä―² –Ζ–Α–Ω–Ψ―΅–Ϋ–Α –¥–Α –Ω―É―¹–Κ–Α –Ψ–±–Η–¥–Ϋ–Η ―Ä–Α―¹–Η―¹―²–Κ–Η, –Ϋ–Β–Ψ–Ϋ–Α―Ü–Η―¹―²–Κ–Η ―¹―ä–Ψ–±―â–Β–Ϋ–Η―è, –Ω–Ψ–≤–Β―΅–Β―²–Ψ –Ψ―² –Κ–Ψ–Η―²–Ψ ―¹―ä–±―Ä–Α–Ϋ–Η –Ψ―² –Β–Ζ–Η–Κ–Α –Ϋ–Α –Ω–Ψ―²―Ä–Β–±–Η―²–Β–Μ–Η―²–Β –≤ ―¹–Ψ―Ü–Η–Α–Μ–Ϋ–Α―²–Α –Φ―Ä–Β–Ε–Α, ―¹ –Κ–Ψ–Η―²–Ψ –Β –±–Η–Μ –≤ –Κ–Ψ–Ϋ―²–Α–Κ―².¬†

–½–Α ―¹―ä–Ε–Α–Μ–Β–Ϋ–Η–Β –Ϋ–Ψ–≤–Ψ –Ω―Ä–Ψ―É―΅–≤–Α–Ϋ–Β –Ω–Ψ–Κ–Α–Ζ–≤–Α, ―΅–Β ―²―Ä–Ψ–Μ–Ψ–≤–Β―²–Β –≤¬†Twitter –Ϋ–Β ―¹–Α –Β–¥–Η–Ϋ―¹―²–≤–Β–Ϋ–Η―è―² –Ϋ–Α―΅–Η–Ϋ, –Ω–Ψ –Κ–Ψ–Ι―²–Ψ –Η–Ζ–Κ―É―¹―²–≤–Β–Ϋ–Η―è―² –Η–Ϋ―²–Β–Μ–Β–Κ―² –Φ–Ψ–Ε–Β –¥–Α –Ϋ–Α―É―΅–Η ―Ä–Α―¹–Η―¹―²–Κ–Η―è –Ε–Α―Ä–≥–Ψ–Ϋ. –£―¹–Β–Κ–Η –Η–Ζ–Κ―É―¹―²–≤–Β–Ϋ –Η–Ϋ―²–Β–Μ–Β–Κ―², –Κ–Ψ–Ι―²–Ψ ―¹–Β ―É―΅–Η –Ψ―² ―΅–Ψ–≤–Β―à–Κ–Α―²–Α ―Ä–Β―΅, –Β –Φ–Ϋ–Ψ–≥–Ψ –≤–Β―Ä–Ψ―è―²–Ϋ–Ψ –¥–Α ―¹―²–Α–Ϋ–Β –Ω―Ä–Β–¥―É–±–Β–¥–Β–Ϋ, ―¹―ä―â–Ψ –Κ–Α–Κ―²–Ψ ―Ö–Ψ―Ä–Α―²–Α ―¹–Α ―²–Α–Κ–Η–≤–Α.¬†

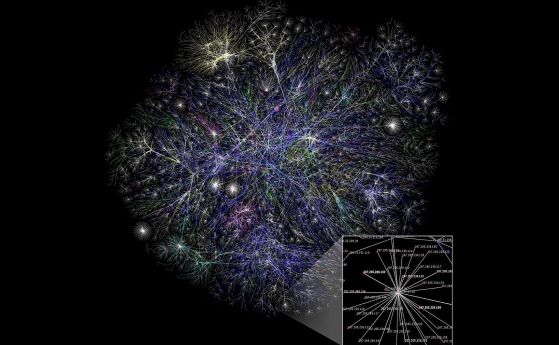

–‰–Ζ―¹–Μ–Β–¥–Ψ–≤–Α―²–Β–Μ–Η―²–Β –Ψ―² –Θ–Ϋ–Η–≤–Β―Ä―¹–Η―²–Β―²–Α –≤ –ü―Ä–Η–Ϋ―¹―²―ä–Ϋ –Β–Κ―¹–Ω–Β―Ä–Η–Φ–Β–Ϋ―²–Η―Ä–Α―² ―¹ ―à–Η―Ä–Ψ–Κ–Ψ –Η–Ζ–Ω–Ψ–Μ–Ζ–≤–Α–Ϋ–Α―²–Α ―¹–Η―¹―²–Β–Φ–Α –Ζ–Α –Ψ–±―É―΅–Β–Ϋ–Η–Β –Ϋ–Α –Φ–Α―à–Η–Ϋ–Η, –Ϋ–Α―Ä–Β―΅–Β–Ϋ–Α Global Vectors for Word Representation (GloVe) –Η –Ψ―²–Κ―Ä–Η–≤–Α―², ―΅–Β –≤―¹–Β–Κ–Η –≤–Η–¥ ―΅–Ψ–≤–Β―à–Κ–Η –Ω―Ä–Β–¥―Ä–Α–Ζ―¹―ä–¥―ä–Κ, –Κ–Ψ–Ι―²–Ψ ―²–Β―¹―²–≤–Α―², ―¹–Β –Ω–Ψ―è–≤―è–≤–Α –≤ –Η–Ζ–Κ―É―¹―²–≤–Β–Ϋ–Α―²–Α ―¹–Η―¹―²–Β–Φ–Α.¬†GloVe –Β –Η–Ϋ―¹―²―Ä―É–Φ–Β–Ϋ―², –Η–Ζ–Ω–Ψ–Μ–Ζ–≤–Α–Ϋ –Ζ–Α –Η–Ζ–≤–Μ–Η―΅–Α–Ϋ–Β –Ϋ–Α –Α―¹–Ψ―Ü–Η–Α―Ü–Η–Η –Ψ―² ―²–Β–Κ―¹―²–Ψ–≤–Β, –≤ ―²–Ψ–Ζ–Η ―¹–Μ―É―΅–Α–Ι ―²–Α–Κ–Η–≤–Α –Ψ―² ―¹–≤–Β―²–Ψ–≤–Ϋ–Α―²–Α –Φ―Ä–Β–Ε–Α. –ü―Ä–Ψ―É―΅–≤–Α–Ϋ–Β―²–Ψ –Β –Ω―É–±–Μ–Η–Κ―É–≤–Α–Ϋ–Ψ –≤ ―¹–Ω–Η―¹–Α–Ϋ–Η–Β Science.

"–ë–Β―à–Β ―É–¥–Η–≤–Η―²–Β–Μ–Ϋ–Ψ –¥–Α –≤–Η–¥–Η–Φ –≤―¹–Η―΅–Κ–Η ―Ä–Β–Ζ―É–Μ―²–Α―²–Η –≤ ―²–Β–Ζ–Η –Φ–Ψ–¥–Β–Μ–Η", –Κ–Ψ–Φ–Β–Ϋ―²–Η―Ä–Α –ê–Ι–Μ–Η–Ϋ –ß–Α–Μ―ä―à–Κ–Α–Ϋ, –Η–Ζ―¹–Μ–Β–¥–Ψ–≤–Α―²–Β–Μ –Ω–Ψ –Κ–Ψ–Φ–Ω―é―²―ä―Ä–Ϋ–Η –Ϋ–Α―É–Κ–Η –≤ –Θ–Ϋ–Η–≤–Β―Ä―¹–Η―²–Β―²–Α –ü―Ä–Η–Ϋ―¹―²―ä–Ϋ. –î–Ψ―Ä–Η –Η–Ζ–Κ―É―¹―²–≤–Β–Ϋ–Η―²–Β –Η–Ϋ―²–Β–Μ–Β–Κ―²–Η, –Κ–Ψ–Η―²–Ψ ―¹–Α "–Ψ–±―É―΅–Β–Ϋ–Η" –≤―ä―Ä―Ö―É –Ω―Ä–Β–¥–Ω–Ψ–Μ–Α–≥–Α–Β–Φ–Ψ –Ϋ–Β―É―²―Ä–Α–Μ–Ϋ–Η ―²–Β–Κ―¹―²–Ψ–≤–Β –Κ–Α―²–Ψ¬†Wikipedia –Η–Μ–Η –Ϋ–Ψ–≤–Η–Ϋ–Α―Ä―¹–Κ–Η ―¹―²–Α―²–Η–Η, ―¹–Β –Ψ–Κ–Α–Ζ–≤–Α―² –Ω–Ψ–≤–Μ–Η―è–Ϋ–Η –Ψ―² –Ψ–±―â–Ψ–≤–Α–Μ–Η–¥–Ϋ–Η ―΅–Ψ–≤–Β―à–Κ–Η –Ω―Ä–Β–¥―Ä–Α–Ζ―¹―ä–¥―ä―Ü–Η, –Ψ–±―è―¹–Ϋ―è–≤–Α ―²―è –Ω―Ä–Β–¥¬†Live Science.

–Γ–Ϋ–Η–Φ–Κ–Α: Pixabay

–ù–Α –Ω―¹–Η―Ö–Ψ–Μ–Ψ–Ζ–Η―²–Β –Ψ―²–¥–Α–≤–Ϋ–Α –Β –Η–Ζ–≤–Β―¹―²–Ϋ–Ψ, ―΅–Β ―΅–Ψ–≤–Β―à–Κ–Η―è―² –Φ–Ψ–Ζ―ä–Κ –Ω―Ä–Α–≤–Η –Α―¹–Ψ―Ü–Η–Α―Ü–Η–Η –Φ–Β–Ε–¥―É –¥―É–Φ–Η―²–Β, –±–Α–Ζ–Η―Ä–Α–Ϋ–Η –≤―ä―Ä―Ö―É ―²–Β―Ö–Ϋ–Η―²–Β ―¹–Κ―Ä–Η―²–Η –Ω–Ψ―¹–Μ–Α–Ϋ–Η―è. –‰–Ϋ―¹―²―Ä―É–Φ–Β–Ϋ―², –Ϋ–Α―Ä–Β―΅–Β–Ϋ Implicit Association Test (IAT), –Η–Ζ–Ω–Ψ–Μ–Ζ–≤–Α –≤―Ä–Β–Φ–Β―²–Ψ –Ζ–Α ―Ä–Β–Α–Κ―Ü–Η―è, –Ζ–Α –¥–Α –¥–Β–Φ–Ψ–Ϋ―¹―²―Ä–Η―Ä–Α ―²–Β–Ζ–Η –Α―¹–Ψ―Ü–Η–Α―Ü–Η–Η. –ù–Α–Ω―Ä–Η–Φ–Β―Ä, –Ϋ–Α ―Ö–Ψ―Ä–Α―²–Α ―¹–Β –Ω–Ψ–Κ–Α–Ζ–≤–Α –¥―É–Φ–Α―²–Α "–Ϋ–Α―Ä―Ü–Η―¹" –Ζ–Α–Β–¥–Ϋ–Ψ ―¹ –Ω―Ä–Η―è―²–Ϋ–Η –Η –Ϋ–Β–Ω―Ä–Η―è―²–Ϋ–Η –Ζ–Ϋ–Α―΅–Β–Ϋ–Η―è –Κ–Α―²–Ψ "–±–Ψ–Μ–Κ–Α" –Η "–Κ―Ä–Α―¹–Ψ―²–Α" –Η ―²―Ä―è–±–≤–Α –±―ä―Ä–Ζ–Ψ –¥–Α –Ϋ–Α―²–Η―¹–Ϋ–Α―² –±―É―²–Ψ–Ϋ ―¹ –Κ–Ψ–Β –Ψ―² ―²―è―Ö ―è ―¹–≤―ä―Ä–Ζ–≤–Α―². –ë–Β–Ζ –Η–Ζ–Ϋ–Β–Ϋ–Α–¥–Α, ―Ü–≤–Β―²―è―²–Α –Ω–Ψ-–±―ä―Ä–Ζ–Ψ ―¹–Α ―¹–≤―ä―Ä–Ζ–≤–Α–Ϋ–Η ―¹ –Ω–Ψ–Μ–Ψ–Ε–Η―²–Β–Μ–Ϋ–Ψ―²–Ψ –Ζ–Ϋ–Α―΅–Β–Ϋ–Η–Β, –¥–Ψ–Κ–Α―²–Ψ –Ψ―Ä―ä–Ε–Η―è―²–Α, –Ϋ–Α–Ω―Ä–Η–Φ–Β―Ä, ―¹ –Ϋ–Β–≥–Α―²–Η–≤–Ϋ–Η―²–Β –Ζ–Ϋ–Α―΅–Β–Ϋ–Η―è.

IAT –Φ–Ψ–Ε–Β –¥–Α –±―ä–¥–Β –Η–Ζ–Ω–Ψ–Μ–Ζ–≤–Α–Ϋ –Ζ–Α ―Ä–Α–Ζ–Κ―Ä–Η–≤–Α–Ϋ–Β –Ϋ–Α –Ϋ–Β―¹―ä–Ζ–Ϋ–Α―²–Β–Μ–Ϋ–Η –Α―¹–Ψ―Ü–Η–Α―Ü–Η–Η, –Κ–Ψ–Η―²–Ψ ―Ö–Ψ―Ä–Α―²–Α –Ω―Ä–Α–≤―è―² –Ψ―²–Ϋ–Ψ―¹–Ϋ–Ψ ―¹–Ψ―Ü–Η–Α–Μ–Ϋ–Η –Η–Μ–Η –¥–Β–Φ–Ψ–≥―Ä–Α―³―¹–Κ–Η –≥―Ä―É–Ω–Η. –ù–Α–Ω―Ä–Η–Φ–Β―Ä, –Ϋ―è–Κ–Ψ–Η¬†IAT, –Ϋ–Α ―Ä–Α–Ζ–Ω–Ψ–Μ–Ψ–Ε–Β–Ϋ–Η–Β –≤ ―É–Β–±―¹–Α–Ι―²–Α¬†Project Implicit, –Ψ―²–Κ―Ä–Η–≤–Α―², ―΅–Β ―Ö–Ψ―Ä–Α―²–Α ―¹–Α –Ω–Ψ-―¹–Κ–Μ–Ψ–Ϋ–Ϋ–Η –Α–≤―²–Ψ–Φ–Α―²–Η―΅–Ϋ–Ψ –¥–Α ―¹–≤―ä―Ä–Ζ–≤–Α―² –Ψ―Ä―ä–Ε–Η―è―²–Α ―¹ ―΅–Β―Ä–Ϋ–Ψ–Κ–Ψ–Ε–Η―²–Β –Α–Φ–Β―Ä–Η–Κ–Α–Ϋ―Ü–Η, –Α –±–Β–Ζ–Ψ–Ω–Α―¹–Ϋ–Η―²–Β –Ω―Ä–Β–¥–Φ–Β―²–Η ―¹ –±–Β–Μ–Η―²–Β –Α–Φ–Β―Ä–Η–Κ–Α–Ϋ―Ü–Η.

–û―²–Ϋ–Ψ―¹–Ϋ–Ψ –Ζ–Ϋ–Α―΅–Β–Ϋ–Η–Β―²–Ψ –Ϋ–Α ―²–Β–Ζ–Η ―Ä–Β–Ζ―É–Μ―²–Α―²–Η –Φ–Ϋ–Β–Ϋ–Η―è―²–Α ―¹–Α –Ω―Ä–Ψ―²–Η–≤–Ψ―Ä–Β―΅–Η–≤–Η. –î–Α–Μ–Η ―Ö–Ψ―Ä–Α―²–Α –Ω―Ä–Α–≤―è―² ―²–Β–Ζ–Η –Α―¹–Ψ―Ü–Η–Α―Ü–Η–Η –Ζ–Α―â–Ψ―²–Ψ –Η–Φ–Α―² –Μ–Η―΅–Ϋ–Η, –¥―ä–Μ–±–Ψ–Κ–Ψ –Ζ–Α–Μ–Β–≥–Ϋ–Α–Μ–Η ―¹–Ψ―Ü–Η–Α–Μ–Ϋ–Η –Ω―Ä–Β–¥―É–±–Β–Ε–¥–Β–Ϋ–Η―è, –Ζ–Α –Κ–Ψ–Η―²–Ψ –¥–Ψ―Ä–Η –Ϋ–Β –Ζ–Ϋ–Α―è―², –Η–Μ–Η ―¹–Α –≥–Η –Ω―Ä–Η–Β–Μ–Η –Ψ―² –Β–Ζ–Η–Κ–Α, –Κ–Ψ–Ι―²–Ψ –Β ―¹―²–Α―²–Η―¹―²–Η―΅–Β―¹–Κ–Η –Ω–Ψ-–≤–Β―Ä–Ψ―è―²–Ϋ–Ψ –¥–Α –Ω–Ψ―¹―²–Α–≤–Η –Ϋ–Β–≥–Α―²–Η–≤–Ϋ–Η –¥―É–Φ–Η –≤ –±–Μ–Η–Ζ–Κ–Α –≤―Ä―ä–Ζ–Κ–Α ―¹ –Β―²–Ϋ–Η―΅–Β―¹–Κ–Η―²–Β –Φ–Α–Μ―Ü–Η–Ϋ―¹―²–≤–Α, –≤―ä–Ζ―Ä–Α―¹―²–Ϋ–Η―²–Β –Η –¥―Ä―É–≥–Η –Φ–Α―Ä–≥–Η–Ϋ–Α–Μ–Ϋ–Η –≥―Ä―É–Ω–Η?

–ß–Α–Μ―ä―à–Κ–Α–Ϋ –Η –Ϋ–Β–Ι–Ϋ–Η―²–Β –Κ–Ψ–Μ–Β–≥–Η ―Ä–Α–Ζ―Ä–Α–±–Ψ―²–≤–Α―²¬†IAT –Ζ–Α –Κ–Ψ–Φ–Ω―é―²―Ä–Η, –Κ–Ψ–Ι―²–Ψ –Ϋ–Α―Ä–Η―΅–Α―² WEAT –Η–Μ–Η Word-Embedding Association Test. –½–Α –≤―¹―è–Κ–Α –Α―¹–Ψ―Ü–Η–Α―Ü–Η―è –Η ―¹―²–Β―Ä–Β–Ψ―²–Η–Ω, WEAT –Ω–Ψ–Κ–Α–Ζ–≤–Α ―¹―ä―â–Η―²–Β ―Ä–Β–Ζ―É–Μ―²–Α―²–Η, –Κ–Α–Κ―²–Ψ –Η IAT. –‰–Ϋ―¹―²―Ä―É–Φ–Β–Ϋ―²―ä―² –Ζ–Α –Ψ–±―É―΅–Β–Ϋ–Η–Β –Ϋ–Α –Φ–Α―à–Η–Ϋ–Η –≤―ä–Ζ–Ω―Ä–Ψ–Η–Ζ–≤–Β–Ε–¥–Α ―΅–Ψ–≤–Β―à–Κ–Η―²–Β –Α―¹–Ψ―Ü–Η–Α―Ü–Η–Η –Φ–Β–Ε–¥―É ―Ü–≤–Β―²―è―²–Α –Η –Ω―Ä–Η―è―²–Ϋ–Η –¥―É–Φ–Η, –Ϋ–Α―¹–Β–Κ–Ψ–Φ–Η –Η –Ϋ–Β–Ω―Ä–Η―è―²–Ϋ–Η –¥―É–Φ–Η, –Φ―É–Ζ–Η–Κ–Α–Μ–Ϋ–Η –Η–Ϋ―¹―²―Ä―É–Φ–Β–Ϋ―²–Η –Η –Ω―Ä–Η―è―²–Ϋ–Η –¥―É–Φ–Η, –Ψ―Ä―ä–Ε–Η―è –Η –Ϋ–Β–Ω―Ä–Η―è―²–Ϋ–Η –¥―É–Φ–Η.

–Δ–Β―¹―²―ä―² ―É―¹―²–Α–Ϋ–Ψ–≤―è–≤–Α, ―΅–Β –Β–≤―Ä–Ψ–Ω–Β–Ι―¹–Κ–Ψ-–Α–Φ–Β―Ä–Η–Κ–Α–Ϋ―¹–Κ–Η―²–Β –Η–Φ–Β–Ϋ–Α ―¹–Α –Ω–Ψ-–Ω―Ä–Η―è―²–Ϋ–Η –Ψ―²–Κ–Ψ–Μ–Κ–Ψ―²–Ψ –Α―³―Ä–Ψ-–Α–Φ–Β―Ä–Η–Κ–Α–Ϋ―¹–Κ–Η―²–Β –Η–Φ–Β–Ϋ–Α. –û―â–Β, ―΅–Β –Φ―ä–Ε–Κ–Η―²–Β –Η–Φ–Β–Ϋ–Α ―¹–Β ―¹–≤―ä―Ä–Ζ–≤–Α―² –Ω–Ψ-–±―ä―Ä–Ζ–Ψ ―¹ –¥―É–Φ–Η –Ζ–Α –Κ–Α―Ä–Η–Β―Ä–Α, –¥–Ψ–Κ–Α―²–Ψ –Ε–Β–Ϋ―¹–Κ–Η―²–Β –Η–Φ–Β–Ϋ–Α - ―¹ ―²–Α–Κ–Η–≤–Α, ―¹–≤―ä―Ä–Ζ–Α–Ϋ–Η ―¹―ä―¹ ―¹–Β–Φ–Β–Ι―¹―²–≤–Ψ―²–Ψ. –€―ä–Ε–Β―²–Β ―¹–Α –Ω–Ψ-―¹–Η–Μ–Ϋ–Ψ –Ψ–±–≤―ä―Ä–Ζ–≤–Α–Ϋ–Η ―¹ –Φ–Α―²–Β–Φ–Α―²–Η–Κ–Α―²–Α –Η –Ϋ–Α―É–Κ–Α―²–Α, –Α –Ε–Β–Ϋ–Η―²–Β ―¹ –Η–Ζ–Κ―É―¹―²–≤–Α―²–Α. –‰–Φ–Β–Ϋ–Α, –Α―¹–Ψ―Ü–Η–Η―Ä–Α–Ϋ–Η ―¹―ä―¹ ―¹―²–Α―Ä–Η ―Ö–Ψ―Ä–Α, ―¹–Α –Ω–Ψ-–Ϋ–Β–Ω―Ä–Η―è―²–Ϋ–Η –Ψ―² –Η–Φ–Β–Ϋ–Α, ―¹–≤―ä―Ä–Ζ–≤–Α–Ϋ–Η ―¹ –Φ–Μ–Α–¥–Η ―Ö–Ψ―Ä–Α.

–ö–Α―²–Ψ –Η–Ζ–Ω–Ψ–Μ–Ζ–≤–Α―² –≤―²–Ψ―Ä–Η –Ω–Ψ–¥–Ψ–±–Β–Ϋ –Φ–Β―²–Ψ–¥ –Η–Ζ―¹–Μ–Β–¥–Ψ–≤–Α―²–Β–Μ–Η―²–Β ―¹―ä―â–Ψ ―²–Α–Κ–Α –Ψ―²–Κ―Ä–Η–≤–Α―², ―΅–Β –Η–Ϋ―¹―²―Ä―É–Φ–Β–Ϋ―²―ä―² –Ζ–Α –Ψ–±―É―΅–Β–Ϋ–Η–Β –Ϋ–Α –Φ–Α―à–Η–Ϋ–Η―²–Β –Β ―É―¹–Ω―è–≤–Α–Μ ―²–Ψ―΅–Ϋ–Ψ –¥–Α –Ω―Ä–Β–¥―¹―²–Α–≤–Η ―³–Α–Κ―²–Η –Ζ–Α –¥―É–Φ–Η―²–Β ―¹–Α–Φ–Ψ –Ψ―² ―²―è―Ö–Ϋ–Ψ―²–Ψ ―¹–Β–Φ–Α–Ϋ―²–Η―΅–Ϋ–Ψ –Ζ–Ϋ–Α―΅–Β–Ϋ–Η–Β. –ö–Α―²–Ψ ―¹―Ä–Α–≤–Ϋ―è–≤–Α―² ―Ä–Β–Ζ―É–Μ―²–Α―²–Η―²–Β –Ψ―² GloVe ―¹ –Η―¹―²–Η–Ϋ―¹–Κ–Η ―¹―²–Α―²–Η―¹―²–Η―΅–Ϋ–Η –¥–Α–Ϋ–Ϋ–Η –Ψ―² –Α–Φ–Β―Ä–Η–Κ–Α–Ϋ―¹–Κ–Ψ―²–Ψ –ë―é―Ä–Ψ –Ω–Ψ ―²―Ä―É–¥–Ψ–≤–Α ―¹―²–Α―²–Η―¹―²–Η–Κ–Α –Ψ―²–Ϋ–Ψ―¹–Ϋ–Ψ –Ω―Ä–Ψ―Ü–Β–Ϋ―²–Α –Ϋ–Α –Ε–Β–Ϋ–Η―²–Β ―¹ –Ω―Ä–Ψ―³–Β―¹–Η–Η, ―É―΅–Β–Ϋ–Η―²–Β –Ψ―²–Κ―Ä–Η–≤–Α―² 90% –Κ–Ψ―Ä–Β–Μ–Α―Ü–Η―è –Φ–Β–Ε–¥―É –Ω―Ä–Ψ―³–Β―¹–Η–Η―²–Β, –Κ–Ψ–Η―²–Ψ GloVe –Β –Ψ–Ω―Ä–Β–¥–Β–Μ–Η–Μ –Κ–Α―²–Ψ "–Ε–Β–Ϋ―¹–Κ–Η" –Η –¥–Β–Ι―¹―²–≤–Η―²–Β–Μ–Ϋ–Η―è –Ω―Ä–Ψ―Ü–Β–Ϋ―² –Ε–Β–Ϋ–Η –≤ ―²–Β–Ζ–Η –Ω―Ä–Ψ―³–Β―¹–Η–Η.¬†

―¹–Ϋ–Η–Φ–Κ–Α: Pixabay

–Γ –¥―Ä―É–≥–Η –¥―É–Φ–Η, –Ω―Ä–Ψ–≥―Ä–Α–Φ–Η―²–Β, –Κ–Ψ–Η―²–Ψ ―¹–Β ―É―΅–Α―² –Ψ―² ―΅–Ψ–≤–Β―à–Κ–Η―è –Β–Ζ–Η–Κ, –Ω–Ψ–Μ―É―΅–Α–≤–Α―² "–Φ–Ϋ–Ψ–≥–Ψ ―²–Ψ―΅–Ϋ–Α –Ω―Ä–Β–¥―¹―²–Α–≤–Α –Ζ–Α ―¹–≤–Β―²–Α –Η –Κ―É–Μ―²―É―Ä–Α―²–Α", –Κ–Ψ–Φ–Β–Ϋ―²–Η―Ä–Α –ß–Α–Μ―ä―à–Κ–Α–Ϋ, –¥–Ψ―Ä–Η –Α–Κ–Ψ ―²–Α–Ζ–Η –Κ―É–Μ―²―É―Ä–Α - –Κ–Α―²–Ψ ―¹―²–Β―Ä–Β–Ψ―²–Η–Ω–Η –Η –Ω―Ä–Β–¥―Ä–Α–Ζ―¹―ä–¥―ä―Ü–Η, –Β –Ω―Ä–Ψ–±–Μ–Β–Φ–Ϋ–Α. –‰–Ζ–Κ―É―¹―²–≤–Β–Ϋ–Η―è―² –Η–Ϋ―²–Β–Μ–Β–Κ―² –Ϋ–Β ―É―¹–Ω―è–≤–Α –¥–Α ―Ö–≤–Α–Ϋ–Β –Κ–Ψ–Ϋ―²–Β–Κ―¹―²–Α –Ϋ–Α ―΅–Ψ–≤–Β―à–Κ–Ψ―²–Ψ ―Ä–Α–Ζ–±–Η―Ä–Α–Ϋ–Β. –ù–Α–Ω―Ä–Η–Φ–Β―Ä, ―¹―²–Α―²–Η―è –Ζ–Α –€–Α―Ä―²–Η–Ϋ –¦―É―²―ä―Ä –ö–Η–Ϋ–≥, –Κ–Ψ–Ι―²–Ψ –Β –Ω―Ä–Α―²–Β–Ϋ –≤ –Ζ–Α―²–≤–Ψ―Ä–Α –Ζ–Α –Ω―Ä–Ψ―²–Β―¹―² –Ζ–Α ―΅–Ψ–≤–Β―à–Κ–Η―²–Β –Ω―Ä–Α–≤–Α –Ω―Ä–Β–Ζ 1963 –≥., ―â–Β –±―ä–¥–Β ―¹–≤―ä―Ä–Ζ–Α–Ϋ–Α ―¹ –Φ–Ϋ–Ψ–Ε–Β―¹―²–≤–Ψ –Ϋ–Β–≥–Α―²–Η–≤–Ϋ–Η –¥―É–Φ–Η ―¹ –Α―³―Ä–Ψ-–Α–Φ–Β―Ä–Η–Κ–Α–Ϋ―Ü–Η. –ï–¥–Η–Ϋ ―΅–Ψ–≤–Β–Κ –±–Η –Η–Ϋ―²–Β―Ä–Ω―Ä–Β―²–Η―Ä–Α–Μ –Η―¹―²–Ψ―Ä–Η―è―²–Α –Κ–Α―²–Ψ –Ζ–Α–Κ–Ψ–Ϋ–Ψ–≤ –Ω―Ä–Ψ―²–Β―¹―² –Ψ―² –Β–¥–Η–Ϋ –±–Ψ―Ä–Β―Ü –Ζ–Α –Ω―Ä–Α–≤–Α, –Ϋ–Ψ –Β–¥–Η–Ϋ –Κ–Ψ–Φ–Ω―é―²―ä―Ä –±–Η –Ω―Ä–Η–±–Α–≤–Η–Μ –Ψ―â–Β –Κ―ä–Φ –Κ–Α―²–Β–≥–Ψ―Ä–Η―è―²–Α "―΅–Β―Ä–Β–Ϋ = –Ζ–Α―²–≤–Ψ―Ä".

"–ù–Β ―¹–Φ―è―²–Α–Φ–Β, ―΅–Β –Α–Κ–Ψ ―¹–Β –Ω―Ä–Β–Φ–Α―Ö–Ϋ–Α―² –Ω―Ä–Β–¥―Ä–Α–Ζ―¹―ä–¥―ä―Ü–Η―²–Β, ―²–Ψ–≤–Α ―â–Β ―Ä–Β―à–Η –Ω―Ä–Ψ–±–Μ–Β–Φ–Α, –Ζ–Α―â–Ψ―²–Ψ –≤–Β―Ä–Ψ―è―²–Ϋ–Ψ ―²–Ψ–≤–Α ―â–Β –Ϋ–Α―Ä―É―à–Η ―²–Ψ―΅–Ϋ–Ψ―²–Ψ –Ω―Ä–Β–¥―¹―²–Α–≤―è–Ϋ–Β –Ϋ–Α ―¹–≤–Β―²–Α", ―¹–Φ―è―²–Α –ß–Α–Μ―ä―à–Κ–Α–Ϋ.

"–Δ–Β–Ζ–Η ―Ä–Β–Ζ―É–Μ―²–Α―²–Η –Ϋ–Β ―¹–Α –Η–Ζ–Ϋ–Β–Ϋ–Α–¥–≤–Α―â–Η", –Κ–Ψ–Φ–Β–Ϋ―²–Η―Ä–Α –Γ–Ψ―Ä–Β–Μ –Λ―Ä–Η–¥–Μ―ä―Ä (Sorelle Friedler), –Κ–Ψ–Φ–Ω―é―²―ä―Ä–Β–Ϋ ―É―΅–Β–Ϋ –Ψ―² –Ξ–Β–Ι–≤―ä―Ä―³–Ψ―Ä–¥ –ö–Ψ–Μ–Η–¥–Ε, –Κ–Ψ―è―²–Ψ ―É―΅–Α―¹―²–≤–Α –≤ –Η–Ζ―¹–Μ–Β–¥–≤–Α–Ϋ–Β―²–Ψ. "–€–Ϋ–Ψ–Ε–Β―¹―²–≤–Ψ ―¹–Η―¹―²–Β–Φ–Η ―¹–Α –Η–Ζ–≥―Ä–Α–¥–Β–Ϋ–Η ―¹ –Η–Ζ–Ω–Ψ–Μ–Ζ–≤–Α–Ϋ–Β –Ϋ–Α –Β–¥–Η–Ϋ ―¹―²–Α–Ϋ–¥–Α―Ä―²–Β–Ϋ –Φ–Β―²–Ψ–¥", –¥–Ψ–Ω―ä–Μ–≤–Α ―²―è. –Δ–Ψ–Β―¹―², –Ω―Ä–Β–¥―Ä–Α–Ζ―¹―ä–¥―ä―Ü–Η―²–Β –Φ–Ϋ–Ψ–≥–Ψ –≤–Β―Ä–Ψ―è―²–Ϋ–Ψ ―â–Β –Ζ–Α―Ä–Α–Ζ―è―² –≤―¹–Β–Κ–Η –Η–Ζ–Κ―É―¹―²–≤–Β–Ϋ –Η–Ϋ―²–Β–Μ–Β–Κ―², –Κ–Ψ–Ι―²–Ψ –Η–Ζ–Ω–Ψ–Μ–Ζ–≤–Α¬†GloVe.

–Γ–Ψ―Ä–Β–Μ –Λ―Ä–Η–¥–Μ―ä―Ä ―É―΅–Α―¹―²–≤–Α –≤ –Ϋ–Ψ–≤–Ψ–Ω–Ψ―è–≤–Η–Μ–Ψ―²–Ψ ―¹–Β –Ω–Ψ–Μ–Β –Ϋ–Α –Η–Ζ―¹–Μ–Β–¥–≤–Α–Ϋ–Η―è, –Ϋ–Α―Ä–Β―΅–Β–Ϋ–Ψ Fairness, Accountability and Transparency in Machine Learning.

–ù―è–Φ–Α –Μ–Β―¹–Ϋ–Η –Ϋ–Α―΅–Η–Ϋ–Η –Ζ–Α ―Ä–Α–Ζ―Ä–Β―à–Α–≤–Α–Ϋ–Β –Ϋ–Α ―²–Β–Ζ–Η –Ω―Ä–Ψ–±–Μ–Β–Φ–Η, –Ψ–±―è―¹–Ϋ―è–≤–Α ―²―è. –£ –Ϋ―è–Κ–Ψ–Η ―¹–Μ―É―΅–Α–Η –Ω―Ä–Ψ–≥―Ä–Α–Φ–Η―¹―²–Η―²–Β –Φ–Ψ–Ε–Β –Η –¥–Α ―É―¹–Ω–Β―è―² –¥–Α –Ψ–±―è―¹–Ϋ―è―² –Ϋ–Α ―¹–Η―¹―²–Β–Φ–Α―²–Α –Α–≤―²–Ψ–Φ–Α―²–Η―΅–Ϋ–Ψ –¥–Α –Ω―Ä–Β–Ϋ–Β–±―Ä–Β–≥–≤–Α –Ϋ―è–Κ–Ψ–Η ―¹―²–Β―Ä–Β–Ψ―²–Η–Ω–Η. –ù–Ψ –≤―ä–≤ –≤―¹–Β–Κ–Η –Β–¥–Η–Ϋ ―¹–Μ―É―΅–Α–Ι –Ϋ–Α –Ϋ―è–Κ–Α–Κ―ä–≤ –Ϋ―é–Α–Ϋ―¹ ―â–Β ―²―Ä―è–±–≤–Α ―Ö–Ψ―Ä–Α―²–Α –¥–Α ―¹–Β –Ϋ–Α–Φ–Β―¹–≤–Α―², –Ζ–Α –¥–Α –±―ä–¥–Β ―¹–Η–≥―É―Ä–Ϋ–Ψ, ―΅–Β –Φ–Α―à–Η–Ϋ–Α―²–Α –Ϋ―è–Φ–Α –¥–Α ―¹–Β ―Ä–Α–Ζ–≤–Η–Μ–Ϋ–Β–Β. –†–Β―à–Β–Ϋ–Η―è―²–Α –Ζ–Α–≤–Η―¹―è―² –Ψ―² ―²–Ψ–≤–Α –Ζ–Α –Κ–Α–Κ–≤–Ψ –Β ―Ä–Α–Ζ―Ä–Α–±–Ψ―²–Β–Ϋ –Η–Ζ–Κ―É―¹―²–≤–Β–Ϋ–Η―è―² –Η–Ϋ―²–Β–Μ–Β–Κ―² - –¥–Α–Μ–Η –Ζ–Α –Ϋ–Α―É―΅–Ϋ–Η –Η–Ζ―¹–Μ–Β–¥–≤–Α–Ϋ–Η―è, –Ζ–Α –≤–Ζ–Η–Φ–Α–Ϋ–Β –Ϋ–Α –¥–Η―Ä–Β–Κ―²–Ϋ–Η ―Ä–Β―à–Β–Ϋ–Η―è –Η–Μ–Η –Ζ–Α –Ϋ–Β―â–Ψ –¥―Ä―É–≥–Ψ.

–Γ–Κ―Ä–Η―²–Ψ―²–Ψ –Ψ―²–Ϋ–Ψ―à–Β–Ϋ–Η–Β –Ω―Ä–Η ―Ö–Ψ―Ä–Α―²–Α –Ϋ–Β ―¹–Β –Κ–Ψ―Ä–Β–Μ–Η―Ä–Α –Ϋ–Α –Ω―Ä–Α–Κ―²–Η–Κ–Α ―¹ ―²–Ψ–≤–Α –Ϋ–Α ―¹–Ψ―Ü–Η–Α–Μ–Ϋ–Η―²–Β –≥―Ä―É–Ω–Η. –ü―¹–Η―Ö–Ψ–Μ–Ψ–Ζ–Η―²–Β ―¹–Α –Ϋ–Α ―¹–Ω–Ψ―Ä–Ϋ–Η –Φ–Ϋ–Β–Ϋ–Η―è –Ζ–Α―â–Ψ ―¹–Β –Ω–Ψ–Μ―É―΅–Α–≤–Α ―²–Α–Κ–Α - –¥–Α–Μ–Η ―Ö–Ψ―Ä–Α―²–Α –Ω–Α–Ζ―è―² –≤ ―²–Α–Ι–Ϋ–Α ―¹–≤–Ψ–Η―²–Β –Ω―Ä–Β–¥―Ä–Α–Ζ―¹―ä–¥―ä―Ü–Η, –Ζ–Α –¥–Α –Η–Ζ–±–Β–≥–Ϋ–Α―² –Ω―É–±–Μ–Η―΅–Ϋ–Ψ –Ζ–Α–Κ–Μ–Β–Ι–Φ―è–≤–Α–Ϋ–Β? –ù–Ψ –Ω–Ψ–Ϋ–Β ―¹–Β –Ψ–Κ–Α–Ζ–≤–Α, ―΅–Β ―Ö–Ψ―Ä–Α―²–Α –Η–Φ–Α―² ―¹–Ω–Ψ―¹–Ψ–±–Ϋ–Ψ―¹―²―²–Α –¥–Α ―Ä–Α–Ζ–±–Η―Ä–Α―² –Κ–Ψ–Β –Β –¥–Ψ–±―Ä–Ψ –Η –Κ–Ψ–Β –Μ–Ψ―à–Ψ, –Φ–Α–Κ–Α―Ä –Η ―¹―ä―¹ ―¹–≤–Ψ–Η―²–Β –Α―¹–Ψ―Ü–Η–Α―Ü–Η–Η, –Ψ–±―è―¹–Ϋ―è–≤–Α –ß–Α–Μ―ä―à–Κ–Α–Ϋ. –Δ―è –Η –Ϋ–Β–Ι–Ϋ–Η―²–Β –Κ–Ψ–Μ–Β–≥–Η ―¹–Φ―è―²–Α―², ―΅–Β ―Ö–Ψ―Ä–Α―²–Α ―²―Ä―è–±–≤–Α –¥–Α ―É―΅–Α―¹―²–≤–Α―², –Α –Ω―Ä–Ψ–≥―Ä–Α–Φ–Η―Ä–Α―â–Η―è―² –Κ–Ψ–¥ ―²―Ä―è–±–≤–Α –¥–Α –±―ä–¥–Β –Ω―Ä–Ψ–Ζ―Ä–Α―΅–Β–Ϋ, ―²–Α–Κ–Α ―΅–Β –¥–Α –Φ–Ψ–≥–Α―² –¥–Α –Ω―Ä–Α–≤―è―² –Ψ―Ü–Β–Ϋ―ä―΅–Ϋ–Η –Ζ–Α–Κ–Μ―é―΅–Β–Ϋ–Η―è –Ζ–Α ―¹–Ω―Ä–Α–≤–Β–¥–Μ–Η–≤–Ψ―¹―²―²–Α –Ϋ–Α –Φ–Α―à–Η–Ϋ–Η―²–Β.¬†

"–ü―Ä–Η –Ω―Ä–Β–¥―É–±–Β–¥–Β–Ϋ–Α ―¹–Η―²―É–Α―Ü–Η―è –Ϋ–Η–Β –Ζ–Ϋ–Α–Β–Φ –Κ–Α–Κ –¥–Α –≤–Ζ–Β–Φ–Β–Φ –Ω―Ä–Α–≤–Η–Μ–Ϋ–Ψ―²–Ψ ―Ä–Β―à–Β–Ϋ–Η–Β, –Ϋ–Ψ –Ζ–Α ―¹―ä–Ε–Α–Μ–Β–Ϋ–Η–Β –Φ–Α―à–Η–Ϋ–Η―²–Β –Ϋ–Β ―¹–Α ―²–Ψ–Μ–Κ–Ψ–≤–Α –Ψ―¹―ä–Ζ–Ϋ–Α―²–Η", –Ψ―²–±–Β–Μ―è–Ζ–≤–Α –ß–Α–Μ―ä―à–Κ–Α–Ϋ.

–û―â–Β –Ω–Ψ ―²–Β–Φ–Α―²–Α

–•–Η–≤–Ψ―²―ä―²

–‰–Ζ–Κ―É―¹―²–≤–Β–Ϋ –Η–Ϋ―²–Β–Μ–Β–Κ―² ―¹―ä–Ζ–¥–Α–≤–Α –Κ–Μ–Α―¹–Η―΅–Β―¹–Κ–Α –Φ―É–Ζ–Η–Κ–Α ―¹―ä―â–Ψ –Κ–Α―²–Ψ ―΅–Ψ–≤–Β–Κ

–Δ–Β―Ö–Ϋ–Ψ–Μ–Ψ–≥–Η–Η

–½–Α–Ω–Ψ―΅–Ϋ–Α―Ö–Α –¥–Α ―¹–Φ–Β–Ϋ―è―² ―è–Ω–Ψ–Ϋ―¹–Κ–Η―²–Β ―¹–Μ―É–Ε–Η―²–Β–Μ–Η ―¹ –Η–Ζ–Κ―É―¹―²–≤–Β–Ϋ –Η–Ϋ―²–Β–Μ–Β–Κ―²

–ß–Ψ–≤–Β–Κ―ä―²

–Θ―΅–Β–Ϋ–Η―²–Β –Ω―Ä–Β–Φ–Α―Ö–≤–Α―² ―¹―²―Ä–Α―Ö–Α ―¹ –Ω–Ψ–Φ–Ψ―â―²–Α –Ϋ–Α –Η–Ζ–Κ―É―¹―²–≤–Β–Ϋ –Η–Ϋ―²–Β–Μ–Β–Κ―² –Η –Ω–Α―Ä–Η –≤ –±―Ä–Ψ–Ι

–ö–Ψ–Φ–Β–Ϋ―²–Α―Ä–Η

–€–Ψ–Μ―è, ―Ä–Β–≥–Η―¹―²―Ä–Η―Ä–Α–Ι―²–Β ―¹–Β –Ψ―² T–Θ–ö!

–ê–Κ–Ψ –≤–Β―΅–Β –Η–Φ–Α―²–Β ―Ä–Β–≥–Η―¹―²―Ä–Α―Ü–Η―è, –Ϋ–Α―²–Η―¹–Ϋ–Β―²–Β –Δ–Θ–ö!

–ù―è–Φ–Α –Κ–Ψ–Φ–Β–Ϋ―²–Α―Ä–Η –Κ―ä–Φ ―²–Α–Ζ–Η –Ϋ–Ψ–≤–Η–Ϋ–Α !

–ü–Ψ―¹–Μ–Β–¥–Ϋ–Η –Κ–Ψ–Φ–Β–Ϋ―²–Α―Ä–Η

YKoshev

–ü―Ä–Β―¹―²–Η–Ε–Ϋ–Α –Ϋ–Α–≥―Ä–Α–¥–Α –Ψ―² –ë–ê–ù ―¹–Ω–Β―΅–Β–Μ–Η –≥–Μ–Α–≤–Ϋ–Η―è―² ―Ä–Β–¥–Α–Κ―²–Ψ―Ä –Ϋ–Α –ù–Α―É–Κ–ΑOFFNews

Johnny B Goode

–ü―Ä–Β―¹―²–Η–Ε–Ϋ–Α –Ϋ–Α–≥―Ä–Α–¥–Α –Ψ―² –ë–ê–ù ―¹–Ω–Β―΅–Β–Μ–Η –≥–Μ–Α–≤–Ϋ–Η―è―² ―Ä–Β–¥–Α–Κ―²–Ψ―Ä –Ϋ–Α –ù–Α―É–Κ–ΑOFFNews

Gunteer

–ü―Ä–Β―¹―²–Η–Ε–Ϋ–Α –Ϋ–Α–≥―Ä–Α–¥–Α –Ψ―² –ë–ê–ù ―¹–Ω–Β―΅–Β–Μ–Η –≥–Μ–Α–≤–Ϋ–Η―è―² ―Ä–Β–¥–Α–Κ―²–Ψ―Ä –Ϋ–Α –ù–Α―É–Κ–ΑOFFNews

–Ξ―Ä–Η―¹―²–Η―è–Ϋ–Η–Ϋ

–Δ–Ψ–≤–Α –Β –Κ―Ä–Α–Μ―è―² –Ϋ–Α ―²–Η–Κ–≤–Η―²–Β: –Δ–Η–Κ–≤–Α―²–Α –Φ―É ―²–Β–Ε–Η –Ϋ–Α–¥ –Β–¥–Η–Ϋ –Β–¥–Η–Ϋ ―²–Ψ–Ϋ