–Ь–Њ–і–µ–ї–Є—В–µ –љ–∞ –Є–Ј–Ї—Г—Б—В–≤–µ–љ–Є—П –Є–љ—В–µ–ї–µ–Ї—В –Љ–Њ–≥–∞—В –і–∞ —Б–µ —Б–∞–Љ–Њ—А–∞–Ј—А—Г—И–∞—В, –њ—А–µ–≤—А—К—Й–∞–є–Ї–Є –Њ—А–Є–≥–Є–љ–∞–ї–љ–Њ—В–Њ —Б—К–і—К—А–ґ–∞–љ–Є–µ –≤ –љ–µ–њ–Њ–њ—А–∞–≤–Є–Љ–Њ –±—К–ї–љ—Г–≤–∞–љ–µ —Б–∞–Љ–Њ –Ј–∞ –љ—П–Ї–Њ–ї–Ї–Њ –њ–Њ–Ї–Њ–ї–µ–љ–Є—П, —Б–Њ—З–Є –Є–Ј—Б–ї–µ–і–≤–∞–љ–µ, –њ—Г–±–ї–Є–Ї—Г–≤–∞–љ–Њ¬†–љ–∞—Б–Ї–Њ—А–Њ –≤ Nature.

–°–Ї–Њ—А–Њ—И–љ–Њ—В–Њ –њ—А–Њ—Г—З–≤–∞–љ–µ –њ–Њ–і—З–µ—А—В–∞–≤–∞ –љ–∞—А–∞—Б—В–≤–∞—Й–Є—П —А–Є—Б–Ї –Њ—В —Б—А–Є–≤ –љ–∞ –Љ–Њ–і–µ–ї–Є—В–µ –љ–∞ AI –≤ —А–µ–Ј—Г–ї—В–∞—В –љ–∞ —Б–∞–Љ–Њ–Њ–±—Г—З–µ–љ–Є–µ—В–Њ, –њ–Њ–і—З–µ—А—В–∞–≤–∞–є–Ї–Є –љ–µ–Њ–±—Е–Њ–і–Є–Љ–Њ—Б—В—В–∞ –Њ—В –Њ—А–Є–≥–Є–љ–∞–ї–љ–Є –Є–Ј—В–Њ—З–љ–Є—Ж–Є –љ–∞ –і–∞–љ–љ–Є –Є –≤–љ–Є–Љ–∞—В–µ–ї–љ–Њ —Д–Є–ї—В—А–Є—А–∞–љ–µ –љ–∞ –і–∞–љ–љ–Є—В–µ.

–Ъ–∞–Ї–≤–Є –≤–Є–і–Њ–≤–µ AI —Б–∞ –њ–Њ–і–∞—В–ї–Є–≤–Є –љ–∞ —Б—А–Є–≤ –љ–∞ –Љ–Њ–і–µ–ї–∞?

–°—А–Є–≤—К—В –љ–∞ –Љ–Њ–і–µ–ї–∞ –љ–∞—Б—В—К–њ–≤–∞, –Ї–Њ–≥–∞—В–Њ –Љ–Њ–і–µ–ї—К—В –љ–∞ –Є–Ј–Ї—Г—Б—В–≤–µ–љ–Є—П –Є–љ—В–µ–ї–µ–Ї—В —Б–µ –Њ–±—Г—З–∞–≤–∞ –њ—А–µ–Ї–Њ–Љ–µ—А–љ–Њ –≤—К—А—Е—Г –і–∞–љ–љ–Є, –≥–µ–љ–µ—А–Є—А–∞–љ–Є –Њ—В AI.

вАЮ–°—А–Є–≤—К—В –љ–∞ –Љ–Њ–і–µ–ї–∞ –њ—А–µ–і—Б—В–∞–≤–ї—П–≤–∞ —П–≤–ї–µ–љ–Є–µ, –њ—А–Є –Ї–Њ–µ—В–Њ –Љ–Њ–і–µ–ї–Є—В–µ —Б–µ —А–∞–Ј–њ–∞–і–∞—В –њ–Њ—А–∞–і–Є –±–µ–Ј—А–∞–Ј–±–Њ—А–љ–Њ –Њ–±—Г—З–µ–љ–Є–µ –≤—К—А—Е—Г –Є–Ј–Ї—Г—Б—В–≤–µ–љ–Є –і–∞–љ–љ–ЄвАЬ, –Ј–∞—П–≤—П–≤–∞ –њ—А–µ–і Gizmodo –Ш–ї—П –®—Г–Љ–∞–є–ї–Њ–≤ (Ilia Shumailov), –Є–Ј—Б–ї–µ–і–Њ–≤–∞—В–µ–ї –≤ –Ю–Ї—Б—Д–Њ—А–і—Б–Ї–Є—П —Г–љ–Є–≤–µ—А—Б–Є—В–µ—В –Є –≤–Њ–і–µ—Й –∞–≤—В–Њ—А –љ–∞ —Б—В–∞—В–Є—П—В–∞.

–°–њ–Њ—А–µ–і –љ–Њ–≤–Є—П –і–Њ–Ї—Г–Љ–µ–љ—В –≥–µ–љ–µ—А–∞—В–Є–≤–љ–Є—В–µ –Є–љ—Б—В—А—Г–Љ–µ–љ—В–Є –Ј–∞ –Є–Ј–Ї—Г—Б—В–≤–µ–љ –Є–љ—В–µ–ї–µ–Ї—В, –Ї–∞—В–Њ –љ–∞–њ—А–Є–Љ–µ—А –≥–Њ–ї–µ–Љ–Є—В–µ –µ–Ј–Є–Ї–Њ–≤–Є –Љ–Њ–і–µ–ї–Є, –Љ–Њ–≥–∞—В –і–∞ –њ—А–µ–љ–µ–±—А–µ–≥–љ–∞—В –Њ–њ—А–µ–і–µ–ї–µ–љ–Є —З–∞—Б—В–Є –Њ—В –љ–∞–±–Њ—А–∞ –Њ—В –і–∞–љ–љ–Є –Ј–∞ –Њ–±—Г—З–µ–љ–Є–µ, –Ї–Њ–µ—В–Њ –Ї–∞—А–∞ –Љ–Њ–і–µ–ї–∞ –і–∞ —Б–µ –Њ–±—Г—З–∞–≤–∞ —Б–∞–Љ–Њ –≤—К—А—Е—Г –љ—П–Ї–Њ–Є –Њ—В –і–∞–љ–љ–Є—В–µ.

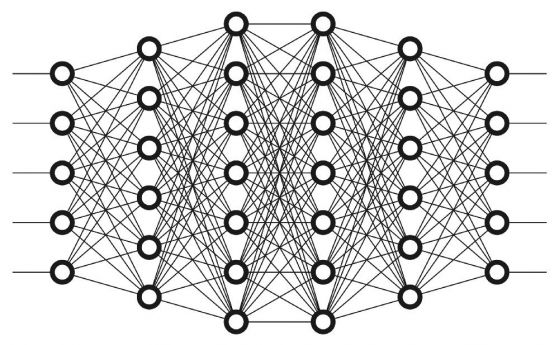

–У–Њ–ї–µ–Љ–Є—В–µ –µ–Ј–Є–Ї–Њ–≤–Є –Љ–Њ–і–µ–ї–Є (LLM - Large Language Models) —Б–∞ –≤–Є–і AI –Љ–Њ–і–µ–ї–Є, –Ї–Њ–Є—В–Њ —Б–µ –Њ–±—Г—З–∞–≤–∞—В –≤—К—А—Е—Г –Њ–≥—А–Њ–Љ–љ–Є –Ї–Њ–ї–Є—З–µ—Б—В–≤–∞ –і–∞–љ–љ–Є, –Ї–Њ–µ—В–Њ –Є–Љ –њ–Њ–Ј–≤–Њ–ї—П–≤–∞ –і–∞ –Є–љ—В–µ—А–њ—А–µ—В–Є—А–∞—В –Є–љ—Д–Њ—А–Љ–∞—Ж–Є—П—В–∞ –≤ —В—П—Е –Є –і–∞ —П –њ—А–Є–ї–∞–≥–∞—В –≤ —А–∞–Ј–ї–Є—З–љ–Є —Б–ї—Г—З–∞–Є –љ–∞ —Г–њ–Њ—В—А–µ–±–∞. LLM –Њ–±–Є–Ї–љ–Њ–≤–µ–љ–Њ —Б–∞ —Б—К–Ј–і–∞–і–µ–љ–Є –Ї–∞–Ї—В–Њ –Ј–∞ —А–∞–Ј–±–Є—А–∞–љ–µ, —В–∞–Ї–∞ –Є –Ј–∞ —Б—К–Ј–і–∞–≤–∞–љ–µ –љ–∞ —В–µ–Ї—Б—В, –Ї–Њ–µ—В–Њ –≥–Є –њ—А–∞–≤–Є –њ–Њ–ї–µ–Ј–љ–Є –Ї–∞—В–Њ —З–∞—В–±–Њ—В–Њ–≤–µ –Є –∞—Б–Є—Б—В–µ–љ—В–Є –љ–∞ AI. –Э–Њ –њ—А–µ–љ–µ–±—А–µ–≥–≤–∞–љ–µ—В–Њ –љ–∞ —З–∞—Б—В–Є –Њ—В —В–µ–Ї—Б—В–∞, –Ї–Њ–є—В–Њ —В–Њ–є —Г–ґ —З–µ—В–µ –Є –≤–Ї–ї—О—З–≤–∞ –≤ —Б–≤–Њ—П—В–∞ –±–∞–Ј–∞ –Њ—В –Ј–љ–∞–љ–Є—П, –Љ–Њ–ґ–µ –і–∞ –њ—А–µ–≤—К—А–љ–µ LLM –≤ –Њ–±–≤–Є–≤–Ї–∞ –љ–∞ –њ—А–µ–і–Є—И–љ–∞—В–∞ –Љ—Г —Б—К—Й–љ–Њ—Б—В —Б—А–∞–≤–љ–Є—В–µ–ї–љ–Њ –±—К—А–Ј–Њ, —Г—Б—В–∞–љ–Њ–≤—П–≤–∞ –Є–Ј—Б–ї–µ–і–Њ–≤–∞—В–µ–ї—Б–Ї–Є—П—В –µ–Ї–Є–њ.

вАЮ–Т —А–∞–љ–љ–Є—П —Б—В–∞–і–Є–є –љ–∞ —Б—А–Є–≤ –љ–∞ –Љ–Њ–і–µ–ї–∞ –њ—К—А–≤–Є—В–µ –Љ–Њ–і–µ–ї–Є –≥—Г–±—П—В –≤–∞—А–Є–∞—В–Є–≤–љ–Њ—Б—В, –≥—Г–±–µ–є–Ї–Є –њ—А–Њ–Є–Ј–≤–Њ–і–Є—В–µ–ї–љ–Њ—Б—В –≤—К—А—Е—Г –Љ–Є–љ–Њ—А–Є—В–∞—А–љ–Є –і–∞–љ–љ–ЄвАЬ, –њ–Њ—Б–Њ—З–≤–∞ –®—Г–Љ–∞–є–ї–Њ–≤. вАЮ–Т –Ї—К—Б–љ–Є—П —Б—В–∞–і–Є–є –љ–∞ —Б—А–Є–≤–∞ –Љ–Њ–і–µ–ї—К—В —Б–µ —А–∞–Ј–њ–∞–і–∞ –љ–∞–њ—К–ї–љ–Њ.вАЬ

–Ш —В–∞–Ї–∞, —В—К–є –Ї–∞—В–Њ –Љ–Њ–і–µ–ї–Є—В–µ –њ—А–Њ–і—К–ї–ґ–∞–≤–∞—В –і–∞ —Б–µ –Њ–±—Г—З–∞–≤–∞—В –≤—К—А—Е—Г –≤—Б–µ –њ–Њ-–Љ–∞–ї–Ї–Њ —В–Њ—З–µ–љ –Є —А–µ–ї–µ–≤–∞–љ—В–µ–љ —В–µ–Ї—Б—В, –Ї–Њ–є—В–Њ —Б–∞–Љ–Є—В–µ –Љ–Њ–і–µ–ї–Є —Б–∞ –≥–µ–љ–µ—А–Є—А–∞–ї–Є, —В–Њ–Ј–Є —А–µ–Ї—Г—А—Б–Є–≤–µ–љ —Ж–Є–Ї—К–ї –≤–Њ–і–Є –і–Њ –і–µ–≥–µ–љ–µ—А–∞—Ж–Є—П –љ–∞ –Љ–Њ–і–µ–ї–∞.

–Я—А–Є–Љ–µ—А –Ј–∞ —Б—А–Є–≤ –љ–∞ –Љ–Њ–і–µ–ї–∞: –¶—К—А–Ї–≤–Є –Є –Ј–∞–є—Ж–Є

–Ш–Ј—Б–ї–µ–і–Њ–≤–∞—В–µ–ї–Є—В–µ –і–∞–≤–∞—В –њ—А–Є–Љ–µ—А –≤ —Б—В–∞—В–Є—П—В–∞, –Ї–∞—В–Њ –Є–Ј–њ–Њ–ї–Ј–≤–∞—В –Љ–Њ–і–µ–ї –Ј–∞ –≥–µ–љ–µ—А–Є—А–∞–љ–µ –љ–∞ —В–µ–Ї—Б—В, –љ–∞—А–µ—З–µ–љ OPT-125m, –Ї–Њ–є—В–Њ —Б–µ –њ—А–µ–і—Б—В–∞–≤—П –њ–Њ–і–Њ–±–љ–Њ –љ–∞ GPT3 –љ–∞ ChatGPT, –љ–Њ —Б –њ–Њ-–Љ–∞–ї—К–Ї –≤—К–≥–ї–µ—А–Њ–і–µ–љ –Њ—В–њ–µ—З–∞—В—К–Ї¬†—Б–њ–Њ—А–µ–і HuggingFace. –Т —Б–ї—Г—З–∞–є, —З–µ –љ–µ —Б—В–µ –љ–∞—П—Б–љ–Њ, –µ–і–Є–љ —Г–Љ–µ—А–µ–љ–Њ –≥–Њ–ї—П–Љ –Љ–Њ–і–µ–ї –њ—А–Њ–Є–Ј–≤–µ–ґ–і–∞ –і–≤–∞ –њ—К—В–Є –њ–Њ–≤–µ—З–µ –µ–Љ–Є—Б–Є–Є –љ–∞ CO2 –Њ—В –ґ–Є–≤–Њ—В–∞ –љ–∞ –µ–і–Є–љ —Б—А–µ–і–љ–Њ—Б—В–∞—В–Є—Б—В–Є—З–µ—Б–Ї–Є –∞–Љ–µ—А–Є–Ї–∞–љ–µ—Ж.

–Х–Ї–Є–њ—К—В –≤—К–≤–µ–ґ–і–∞ –≤ –Љ–Њ–і–µ–ї–∞ —В–µ–Ї—Б—В –љ–∞ —В–µ–Љ–∞ –њ—А–Њ–µ–Ї—В–Є—А–∞–љ–µ –љ–∞ —Ж—К—А–Ї–Њ–≤–љ–Є –Ї—Г–ї–Є –Њ—В 14-—В–Є –≤–µ–Ї. –Т –њ—К—А–≤–Њ—В–Њ –њ–Њ–Ї–Њ–ї–µ–љ–Є–µ –љ–∞ –Є–Ј–≤–µ–ґ–і–∞–љ–Є—П —В–µ–Ї—Б—В –Љ–Њ–і–µ–ї—К—В –≤ –њ–Њ–≤–µ—З–µ—В–Њ —Б–ї—Г—З–∞–Є –µ –±–Є–ї –≤–љ–µ —Б–µ –µ –Њ—В–Ї–ї–Њ–љ—П–≤–∞–ї –Њ—В —В–µ–Љ–∞—В–∞, –Њ–±—Б—К–ґ–і–∞–є–Ї–Є —Б–≥—А–∞–і–Є, –њ–Њ—Б—В—А–Њ–µ–љ–Є –њ—А–Є —А–∞–Ј–ї–Є—З–љ–Є –њ–∞–њ–Є. –Э–Њ –њ—А–Є –і–µ–≤–µ—В–Њ—В–Њ –њ–Њ–Ї–Њ–ї–µ–љ–Є–µ —В–µ–Ї—Б—В–Њ–≤ —А–µ–Ј—Г–ї—В–∞—В –Љ–Њ–і–µ–ї—К—В –Њ–±—Б—К–ґ–і–∞–ї –њ—А–µ–і–Є–Љ–љ–Њ –≥–Њ–ї–µ–Љ–Є –њ–Њ–њ—Г–ї–∞—Ж–Є–Є –Њ—В —З–µ—А–љ–Є, –±–µ–ї–Є, —Б–Є–љ–Є, —З–µ—А–≤–µ–љ–Є –Є –ґ—К–ї—В–Њ–Њ–њ–∞—И–∞—В–Є –Ј–∞–є—Ж–Є. –Ґ—А—П–±–≤–∞ –і–∞ —Б–µ –Њ—В–±–µ–ї–µ–ґ–Є, —З–µ –њ–Њ–≤–µ—З–µ—В–Њ –Њ—В —В—П—Е –љ–µ —Б–∞ —А–µ–∞–ї–љ–Є –≤–Є–і–Њ–≤–µ –Ј–∞–є—Ж–Є.

–°—А–Є–≤—К—В –љ–∞ –Љ–Њ–і–µ–ї–∞ —Б—В–∞–≤–∞ –≤—Б–µ –њ–Њ-—Б–µ—А–Є–Њ–Ј–µ–љ¬†—Б –љ–∞–њ—И—А–µ–і–≤–∞–љ–µ—В–Њ –љ–∞ –њ—А–Њ—Ж–µ—Б–∞ –љ–∞ –љ–∞—Б–Є—Й–∞–љ–µ –љ–∞ –Є–љ—В–µ—А–љ–µ—В —Б—К—Б —Б—К–і—К—А–ґ–∞–љ–Є–µ—В–Њ¬†–Њ—В –Є–Ј–Ї—Г—Б—В–≤–µ–љ –Є–љ—В–µ–ї–µ–Ї—В

–Ґ–Њ–≤–∞, —З–µ –Є–љ—В–µ—А–љ–µ—В –µ –њ—А–µ—В–Њ–≤–∞—А–µ–љ (–Ј–∞–і—А—К—Б—В–µ–љ —Б –Є–љ—Д–Њ—А–Љ–∞—Ж–Є—П) –љ–µ –µ –љ–Њ–≤–Є–љ–∞. –Ъ–∞–Ї—В–Њ –Є–Ј—Б–ї–µ–і–Њ–≤–∞—В–µ–ї–Є—В–µ –њ–Њ—Б–Њ—З–≤–∞—В –≤ —Б—В–∞—В–Є—П—В–∞, –Љ–љ–Њ–≥–Њ –њ—А–µ–і–Є¬†AI –і–∞ –±—К–і–∞—В –њ–Њ–Ј–љ–∞—В–∞ —В–µ–Љ–∞ –љ–∞ –Њ–±—Й–µ—Б—В–≤–µ–љ–Њ—Б—В—В–∞, —Д–µ—А–Љ–Є—В–µ –Ј–∞ —Б—К–і—К—А–ґ–∞–љ–Є–µ –Є —В—А–Њ–ї–Њ–≤–µ—В–µ –≤ –Є–љ—В–µ—А–љ–µ—В —Б–∞ –њ—А–Њ–Є–Ј–≤–µ–ґ–і–∞–ї–Є —Б—К–і—К—А–ґ–∞–љ–Є–µ, –Ј–∞ –і–∞ –Ј–∞–±–ї—Г–і—П—В –∞–ї–≥–Њ—А–Є—В–Љ–Є—В–µ –Ј–∞ —В—К—А—Б–µ–љ–µ –Є –і–∞ –і–∞–і–∞—В –њ—А–Є–Њ—А–Є—В–µ—В –љ–∞ —Б–≤–Њ–Є—В–µ —Г–µ–±—Б–∞–є—В–Њ–≤–µ –Ј–∞ –Ї–ї–Є–Ї–≤–∞–љ–Є—П. –Э–Њ —В–µ–Ї—Б—В—К—В, –≥–µ–љ–µ—А–Є—А–∞–љ –Њ—В –Є–Ј–Ї—Г—Б—В–≤–µ–љ –Є–љ—В–µ–ї–µ–Ї—В, –Љ–Њ–ґ–µ –і–∞ –±—К–і–µ —Б—К–Ј–і–∞–і–µ–љ –њ–Њ-–±—К—А–Ј–Њ –Њ—В —З–Њ–≤–µ—И–Ї–Є—В–µ —Б–ї–Њ–≤–Њ–±–ї—Г–і—Б—В–≤–∞, –Ї–Њ–µ—В–Њ –њ–Њ—А–∞–ґ–і–∞ –Њ–њ–∞—Б–µ–љ–Є—П –≤ –њ–Њ-–≥–Њ–ї—П–Љ –Љ–∞—Й–∞–±.

вАЮ–Т—К–њ—А–µ–Ї–Є —З–µ –≤—К–Ј–і–µ–є—Б—В–≤–Є–µ—В–Њ –љ–∞ –≥–µ–љ–µ—А–Є—А–∞–љ–Є—П –Њ—В AI –Є–љ—В–µ—А–љ–µ—В –≤—К—А—Е—Г —Е–Њ—А–∞—В–∞ –њ—А–µ–і—Б—В–Њ–Є –і–∞ –±—К–і–µ —Г—Б—В–∞–љ–Њ–≤–µ–љ–Њ, –®—Г–Љ–∞–є–ї–Њ–≤ –Є –Ї–Њ–ї–µ–≥–Є—В–µ –Љ—Г —Б—К–Њ–±—Й–∞–≤–∞—В, —З–µ —А–∞–Ј–њ—А–Њ—Б—В—А–∞–љ–µ–љ–Є–µ—В–Њ –љ–∞ –≥–µ–љ–µ—А–Є—А–∞–љ–Њ—В–Њ –Њ—В AI —Б—К–і—К—А–ґ–∞–љ–Є–µ –Њ–љ–ї–∞–є–љ –Љ–Њ–ґ–µ –і–∞ –±—К–і–µ –Њ–њ—Г—Б—В–Њ—И–Є—В–µ–ї–љ–Њ –Ј–∞ —Б–∞–Љ–Є—В–µ –Љ–Њ–і–µ–ї–ЄвАЬ, –Њ—В–±–µ–ї—П–Ј–≤–∞ –Х–Љ–Є–ї–Є –Т–µ–љ–≥–µ—А (Emily Wenger), –Ї–Њ–Љ–њ—О—В—К—А–µ–љ —Г—З–µ–љ –≤ —Г–љ–Є–≤–µ—А—Б–Є—В–µ—В–∞ –Ф—О–Ї, –≤ —Б–≤—К—А–Ј–∞–љ–∞ —Б —В–Њ–≤–∞ —Б—В–∞—В–Є—П –≤ News & Views.

вАЮ–Э–∞—А–µ–і —Б –і—А—Г–≥–Є –љ–µ—Й–∞, —Б—А–Є–≤—К—В –љ–∞ –Љ–Њ–і–µ–ї–∞ –њ–Њ—Б—В–∞–≤—П –њ—А–µ–і–Є–Ј–≤–Є–Ї–∞—В–µ–ї—Б—В–≤–∞ –њ—А–µ–і –Њ–±–µ–Ї—В–Є–≤–љ–Њ—Б—В—В–∞ –љ–∞ –≥–µ–љ–µ—А–∞—В–Є–≤–љ–Є—П AI. –°—А–Є–љ–∞—В–Є—В–µ –Љ–Њ–і–µ–ї–Є –њ—А–µ–љ–µ–±—А–µ–≥–≤–∞—В –њ–Њ-—А—П–і–Ї–Њ —Б—А–µ—Й–∞–љ–Є –µ–ї–µ–Љ–µ–љ—В–Є –Њ—В –Њ–±—Г—З–Є—В–µ–ї–љ–Є—В–µ —Б–Є –і–∞–љ–љ–Є –Є —В–∞–Ї–∞ –љ–µ —Г—Б–њ—П–≤–∞—В –і–∞ –Њ—В—А–∞–Ј—П—В —Б–ї–Њ–ґ–љ–Њ—Б—В—В–∞ –Є –љ—О–∞–љ—Б–Є—В–µ –љ–∞ —Б–≤–µ—В–∞вАЬ, –і–Њ–±–∞–≤—П –Т–µ–љ–≥–µ—А.¬†

–У–Њ–ї–µ–Љ–Є—В–µ —В–µ—Е–љ–Њ–ї–Њ–≥–Є—З–љ–Є –Ї–Њ–Љ–њ–∞–љ–Є–Є –њ—А–µ–і–њ—А–Є–µ–Љ–∞—В –љ—П–Ї–Њ–Є –і–µ–є—Б—В–≤–Є—П, –Ј–∞ –і–∞ –љ–∞–Љ–∞–ї—П—В –Ї–Њ–ї–Є—З–µ—Б—В–≤–Њ—В–Њ —Б—К–і—К—А–ґ–∞–љ–Є–µ, –≥–µ–љ–µ—А–Є—А–∞–љ–Њ –Њ—В –Є–Ј–Ї—Г—Б—В–≤–µ–љ –Є–љ—В–µ–ї–µ–Ї—В, –Ї–Њ–µ—В–Њ —Й–µ –≤–Є–ґ–і–∞ —В–Є–њ–Є—З–љ–Є—П—В –Є–љ—В–µ—А–љ–µ—В —Б—К—А—Д–Є—Б—В. –Я—А–µ–Ј –Љ–∞—А—В Google –Њ–±—П–≤–Є, —З–µ —Й–µ –њ—А–Њ–Љ–µ–љ–Є –∞–ї–≥–Њ—А–Є—В—К–Љ–∞ —Б–Є, –Ј–∞ –і–∞ –њ—А–µ–Љ–∞—Е–љ–µ –њ—А–Є–Њ—А–Є—В–µ—В–∞ –љ–∞ —Б—В—А–∞–љ–Є—Ж–Є, –Ї–Њ–Є—В–Њ –Є–Ј–≥–ї–µ–ґ–і–∞—В –њ—А–µ–і–љ–∞–Ј–љ–∞—З–µ–љ–Є –Ј–∞ —В—К—А—Б–∞—З–Ї–Є, –∞ –љ–µ –Ј–∞ —Е–Њ—А–∞, –Ї–Њ–Є—В–Њ —В—К—А—Б—П—В; —В–Њ–≤–∞ —Б—К–Њ–±—Й–µ–љ–Є–µ –і–Њ–є–і–µ –њ–Њ –њ–Њ–≤–Њ–і –і–Њ–Ї–ї–∞–і –љ–∞ 404 Media –Ј–∞ —В–Њ–≤–∞, —З–µ Google News —Г–≤–µ–ї–Є—З–∞–≤–∞ –±—А–Њ—П –љ–∞ —Б—В–∞—В–Є–Є—В–µ, –≥–µ–љ–µ—А–Є—А–∞–љ–Є –Њ—В –Є–Ј–Ї—Г—Б—В–≤–µ–љ –Є–љ—В–µ–ї–µ–Ї—В.

AI –Љ–Њ–і–µ–ї–Є—В–µ –Њ–±–Є–Ї–љ–Њ–≤–љ–Њ —Б–∞ —В—А–Њ–Љ–∞–≤–Є –Є –∞–≤—В–Њ—А–Є—В–µ –љ–∞ –њ–Њ—Б–ї–µ–і–љ–Њ—В–Њ –њ—А–Њ—Г—З–≤–∞–љ–µ –њ–Њ–і—З–µ—А—В–∞–≤–∞—В, —З–µ –і–Њ—Б—В—К–њ—К—В –і–Њ –Њ—А–Є–≥–Є–љ–∞–ї–љ–Є—П –Є–Ј—В–Њ—З–љ–Є–Ї –љ–∞ –і–∞–љ–љ–Є –Є –≤–љ–Є–Љ–∞—В–µ–ї–љ–Њ—В–Њ —Д–Є–ї—В—А–Є—А–∞–љ–µ –љ–∞ –і–∞–љ–љ–Є—В–µ –≤ —А–µ–Ї—Г—А—Б–Є–≤–љ–Њ –Њ–±—Г—З–µ–љ–Є—В–µ –Љ–Њ–і–µ–ї–Є –Љ–Њ–≥–∞—В –і–∞ –њ–Њ–Љ–Њ–≥–љ–∞—В –Ј–∞ –њ–Њ–і–і—К—А–ґ–∞–љ–µ—В–Њ –љ–∞ –Љ–Њ–і–µ–ї–Є—В–µ –≤ –њ—А–∞–≤–Є–ї–љ–∞ –њ–Њ—Б–Њ–Ї–∞.

–Х–Ї–Є–њ—К—В —Б—К—Й–Њ —В–∞–Ї–∞ –њ—А–µ–і–њ–Њ–ї–∞–≥–∞, —З–µ –Ї–Њ–Њ—А–і–Є–љ–∞—Ж–Є—П—В–∞ –≤ AI –Њ–±—Й–љ–Њ—Б—В—В–∞, —Г—З–∞—Б—В–≤–∞—Й–∞ –≤ —Б—К–Ј–і–∞–≤–∞–љ–µ—В–Њ –љ–∞ LLM, –Љ–Њ–ґ–µ –і–∞ –±—К–і–µ –њ–Њ–ї–µ–Ј–љ–∞ –Ј–∞ –њ—А–Њ—Б–ї–µ–і—П–≤–∞–љ–µ –љ–∞ –њ—А–Њ–Є–Ј—Е–Њ–і–∞ –љ–∞ –Є–љ—Д–Њ—А–Љ–∞—Ж–Є—П—В–∞, –і–Њ–Ї–∞—В–Њ —В—П —Б–µ –њ–Њ–і–∞–≤–∞ –њ—А–µ–Ј –Љ–Њ–і–µ–ї–Є—В–µ.

вАЮ–Т –њ—А–Њ—В–Є–≤–µ–љ —Б–ї—Г—З–∞–євАЬ, –Ј–∞–Ї–ї—О—З–∞–≤–∞ –µ–Ї–Є–њ—К—В, вАЮ–Љ–Њ–ґ–µ –і–∞ —Б—В–∞–љ–µ –≤—Б–µ –њ–Њ-—В—А—Г–і–љ–Њ –і–∞ —Б–µ –Њ–±—Г—З–∞–≤–∞—В –њ–Њ-–љ–Њ–≤–Є –≤–µ—А—Б–Є–Є –љ–∞ LLM –±–µ–Ј –і–Њ—Б—В—К–њ –і–Њ –і–∞–љ–љ–Є, –Ї–Њ–Є—В–Њ —Б–∞ –±–Є–ї–Є –Њ–±—Е–Њ–і–µ–љ–Є –Њ—В –Є–љ—В–µ—А–љ–µ—В –њ—А–µ–і–Є –Љ–∞—Б–Њ–≤–Њ—В–Њ –њ—А–Є–µ–Љ–∞–љ–µ –љ–∞ —В–µ—Е–љ–Њ–ї–Њ–≥–Є—П—В–∞ –Є–ї–Є –і–Є—А–µ–Ї—В–µ–љ –і–Њ—Б—В—К–њ –і–Њ –і–∞–љ–љ–Є, –≥–µ–љ–µ—А–Є—А–∞–љ–Є –Њ—В —Е–Њ—А–∞.вАЬ

–Ф–Њ–±—А–µ –і–Њ—И–ї–Є –≤ –њ—А–µ–Ї—А–∞—Б–љ–Є—П –љ–Њ–≤ AI —Б–≤—П—В!

–°–њ—А–∞–≤–Ї–∞:¬†Shumailov, I., Shumaylov, Z., Zhao, Y. et al. AI models collapse when trained on recursively generated data. Nature 631, 755вАУ759 (2024). https://doi.org/10.1038/s41586-024-07566-y¬†

–Ш–Ј—В–Њ—З–љ–Є–Ї:¬†AI Learning From Its Own Nonsense Might Just Self-Destruct, Experts Warn,¬†Isaac Schultz,¬†Gizmodo

–Ю—Й–µ –њ–Њ —В–µ–Љ–∞—В–∞

–І–Њ–≤–µ–Ї—К—В

AI —Б–Є—Б—В–µ–Љ–∞—В–∞ LaMDA –љ–∞ Google –Ї–∞–Ј–≤–∞, —З–µ –Є–Љ–∞ —Б—К–Ј–љ–∞–љ–Є–µ. –Ф–∞ –є –њ–Њ–≤—П—А–≤–∞–Љ–µ –ї–Є?

–Ґ–µ—Е–љ–Њ–ї–Њ–≥–Є–Є

–Ь–Њ–ґ–µ–Љ –ї–Є –і–∞ —Б–µ –і–Њ–≤–µ—А–Є–Љ –љ–∞ –љ–∞—Г—З–љ–Є –Њ—В–Ї—А–Є—В–Є—П, –љ–∞–њ—А–∞–≤–µ–љ–Є —Б –Љ–∞—И–Є–љ–љ–Њ —Б–∞–Љ–Њ–Њ–±—Г—З–µ–љ–Є–µ?

–Ґ–µ—Е–љ–Њ–ї–Њ–≥–Є–Є

–Ъ–∞–Ї —А–∞–±–Њ—В–Є –і—К–ї–±–Њ–Ї–Њ—В–Њ —Б–∞–Љ–Њ–Њ–±—Г—З–µ–љ–Є–µ –љ–∞ –љ–µ–≤—А–Њ–љ–љ–Є—В–µ –Љ—А–µ–ґ–Є?

–Ъ–Њ–Љ–µ–љ—В–∞—А–Є

–Ь–Њ–ї—П, —А–µ–≥–Є—Б—В—А–Є—А–∞–є—В–µ —Б–µ –Њ—В T–£–Ъ!

–Р–Ї–Њ –≤–µ—З–µ –Є–Љ–∞—В–µ —А–µ–≥–Є—Б—В—А–∞—Ж–Є—П, –љ–∞—В–Є—Б–љ–µ—В–µ –Ґ–£–Ъ!

–Э—П–Љ–∞ –Ї–Њ–Љ–µ–љ—В–∞—А–Є –Ї—К–Љ —В–∞–Ј–Є –љ–Њ–≤–Є–љ–∞ !

–Я–Њ—Б–ї–µ–і–љ–Є –Ї–Њ–Љ–µ–љ—В–∞—А–Є

Johnny B Goode

–Я—А–µ—Б—В–Є–ґ–љ–∞ –љ–∞–≥—А–∞–і–∞ –Њ—В –С–Р–Э —Б–њ–µ—З–µ–ї–Є –≥–ї–∞–≤–љ–Є—П—В —А–µ–і–∞–Ї—В–Њ—А –љ–∞ –Э–∞—Г–Ї–∞OFFNews

Gunteer

–Я—А–µ—Б—В–Є–ґ–љ–∞ –љ–∞–≥—А–∞–і–∞ –Њ—В –С–Р–Э —Б–њ–µ—З–µ–ї–Є –≥–ї–∞–≤–љ–Є—П—В —А–µ–і–∞–Ї—В–Њ—А –љ–∞ –Э–∞—Г–Ї–∞OFFNews

–•—А–Є—Б—В–Є—П–љ–Є–љ

–Ґ–Њ–≤–∞ –µ –Ї—А–∞–ї—П—В –љ–∞ —В–Є–Ї–≤–Є—В–µ: –Ґ–Є–Ї–≤–∞—В–∞ –Љ—Г —В–µ–ґ–Є –љ–∞–і –µ–і–Є–љ –µ–і–Є–љ —В–Њ–љ

dolivo

–°–∞—Е–∞—А–∞ –Њ—З–∞–Ї–≤–∞ 75% —Г–≤–µ–ї–Є—З–µ–љ–Є–µ –љ–∞ –≤–∞–ї–µ–ґ–Є—В–µ –і–Њ 2100 –≥.