–°–ł—Ā—ā–Ķ–ľ–ł—ā–Ķ, –Ņ—Ä–Ķ–ī–Ĺ–į–∑–Ĺ–į—á–Ķ–Ĺ–ł –∑–į –ĺ—ā–ļ—Ä–ł–≤–į–Ĺ–Ķ –Ĺ–į –ī–ł–Ļ–Ņ—Ą–Ķ–Ļ–ļ –≤–ł–ī–Ķ–į - —Ą–į–Ľ—ą–ł–≤–ł –≤–ł–ī–Ķ–ĺ–ļ–Ľ–ł–Ņ–ĺ–≤–Ķ, –ļ–ĺ–ł—ā–ĺ –ľ–į–Ĺ–ł–Ņ—É–Ľ–ł—Ä–į—ā —Ä–Ķ–į–Ľ–Ĺ–ł –ļ–į–ī—Ä–ł —á—Ä–Ķ–∑ –ł–∑–ļ—É—Ā—ā–≤–Ķ–Ĺ –ł–Ĺ—ā–Ķ–Ľ–Ķ–ļ—ā - –ľ–ĺ–≥–į—ā –ī–į –Ī—ä–ī–į—ā –ł–∑–ľ–į–ľ–Ķ–Ĺ–ł, –Ņ–ĺ–ļ–į–∑–į—Ö–į –ļ–ĺ–ľ–Ņ—é—ā—ä—Ä–Ĺ–ł—ā–Ķ —É—á–Ķ–Ĺ–ł –∑–į –Ņ—ä—Ä–≤–ł –Ņ—ä—ā –Ĺ–į –ļ–ĺ–Ĺ—Ą–Ķ—Ä–Ķ–Ĺ—Ü–ł—Ź—ā–į WACV 2021, –ļ–ĺ—Ź—ā–ĺ —Ā–Ķ –Ņ—Ä–ĺ–≤–Ķ–ī–Ķ –ĺ–Ĺ–Ľ–į–Ļ–Ĺ –ĺ—ā 5 –ī–ĺ 9 —Ź–Ĺ—É–į—Ä–ł 2021 –≥–ĺ–ī–ł–Ĺ–į.

–ė–∑—Ā–Ľ–Ķ–ī–ĺ–≤–į—ā–Ķ–Ľ–ł—ā–Ķ –Ņ–ĺ–ļ–į–∑–į—Ö–į, —á–Ķ –Ĺ–ĺ–≤–į –Ĺ–Ķ–≤—Ä–ĺ–Ĺ–Ĺ–į –ľ—Ä–Ķ–∂–į –Ņ–ĺ –ī–ĺ—Ā—ā–į –Ņ—Ä–ĺ—Ā—ā –Ĺ–į—á–ł–Ĺ ‚Äě–∑–į–Ī–Ľ—É–∂–ī–į–≤–į‚Äú –≤—Ā—Ź–ļ–į–ļ–≤–ł –ī–Ķ—ā–Ķ–ļ—ā–ĺ—Ä–ł –∑–į –ī–ł–Ļ–Ņ—Ą–Ķ–Ļ–ļ –≤–ł–ī–Ķ–į, –ļ–ĺ–Ķ—ā–ĺ –ī–Ķ–ľ–ĺ–Ĺ—Ā—ā—Ä–ł—Ä–į –Ĺ–Ķ–Ķ—Ą–Ķ–ļ—ā–ł–≤–Ĺ–ĺ—Ā—ā—ā–į –ī–ĺ—Ä–ł –Ĺ–į –Ĺ–į–Ļ-—É—Ā—ä–≤—ä—Ä—ą–Ķ–Ĺ—Ā—ā–≤–į–Ĺ–ł—ā–Ķ —Ā—ä—Č–Ķ—Ā—ā–≤—É–≤–į—Č–ł —Ā—Ä–Ķ–ī—Ā—ā–≤–į –∑–į –ĺ–Ņ—Ä–Ķ–ī–Ķ–Ľ—Ź–Ĺ–Ķ –Ĺ–į –į–≤—ā–Ķ–Ĺ—ā–ł—á–Ĺ–ĺ—Ā—ā—ā–į –Ĺ–į –Ķ–ī–ł–Ĺ –≤–ł–ī–Ķ–ĺ–ļ–Ľ–ł–Ņ.

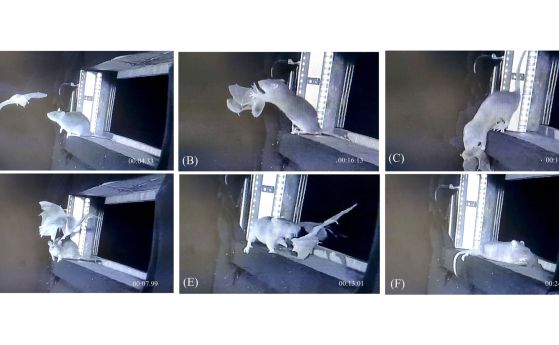

–Ē–Ķ—ā–Ķ–ļ—ā–ĺ—Ä–ł—ā–Ķ –ľ–ĺ–≥–į—ā –ī–į –Ī—ä–ī–į—ā –Ņ–ĺ–Ī–Ķ–ī–Ķ–Ĺ–ł —á—Ä–Ķ–∑ –≤–ľ—ä–ļ–≤–į–Ĺ–Ķ –Ĺ–į —Ā–Ņ–Ķ—Ü–ł–į–Ľ–Ĺ–ł "–ļ–ĺ–Ĺ–ļ—É—Ä–ł—Ä–į—Č–ł —Ā–Ķ" –Ņ—Ä–ł–ľ–Ķ—Ä–ł (–ľ–ĺ–≥–į—ā –ī–į –Ī—ä–ī–į—ā –Ņ—Ä–Ķ–≤–Ķ–ī–Ķ–Ĺ–ł –ļ–į—ā–ĺ "–Ņ—Ä–ĺ—ā–ł–≤–ĺ—Ā—ā–ĺ—Ź—Č–ł" - adversarial examples) –≤—ä–≤ –≤—Ā–Ķ–ļ–ł –ļ–į–ī—ä—Ä –Ĺ–į –≤–ł–ī–Ķ–ĺ—ā–ĺ. –ē—Ą–Ķ–ļ—ā—ä—ā –Ĺ–į–ł—Ā—ā–ł–Ĺ–į –Ķ –ĺ–Ī–Ķ–∑—Ā—ä—Ä—á–ł—ā–Ķ–Ľ–Ķ–Ĺ: –ī–ĺ—Ä–ł –Ĺ–į–Ī—ä—Ä–∑–ĺ –ł–∑–ľ–ł—Ā–Ľ–Ķ–Ŭ†–ī–ł–Ļ–Ņ—Ą–Ķ–Ļ–ļ —Ā–Ķ –ĺ—ā–ļ—Ä–ł–≤–į –ĺ—ā –ī–Ķ—ā–Ķ–ļ—ā–ĺ—Ä–į –ļ–į—ā–ĺ —Ä–Ķ–į–Ľ–Ķ–Ĺ –∑–į–Ņ–ł—Ā. –í—ä–Ņ—Ä–Ķ–ļ–ł —á–Ķ –Ĺ–Ķ–Ķ—Ā—ā–Ķ—Ā—ā–≤–Ķ–Ĺ–ĺ—ā–ĺ –Ņ–ĺ–≤–Ķ–ī–Ķ–Ĺ–ł–Ķ –Ĺ–į —á–ĺ–≤–Ķ–ļ–į –≤—ä–≤ –≤–ł–ī–Ķ–ĺ—ā–ĺ –Ķ –ĺ—á–Ķ–≤–ł–ī–Ķ–Ĺ —Ā –Ņ—Ä–ĺ—Ā—ā–ĺ –ĺ–ļ–ĺ. –ė–∑—Ā–Ľ–Ķ–ī–ĺ–≤–į—ā–Ķ–Ľ–ł—ā–Ķ –ī–Ķ–ľ–ĺ–Ĺ—Ā—ā—Ä–ł—Ä–į—Ö–į –Ņ—Ä–ł–ľ–Ķ—Ä –∑–į —ā–į–ļ–į–≤–į –ł–∑–ľ–į–ľ–į –Ĺ–į –Ņ—Ä–į–ļ—ā–ł–ļ–į.

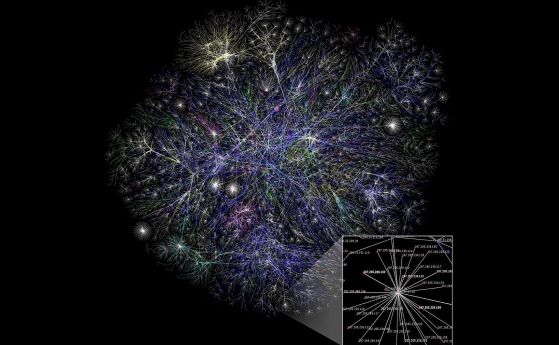

–ü—Ä–ł¬†–ī–ł–Ļ–Ņ—Ą–Ķ–Ļ–ļ–ĺ–≤–Ķ—ā–Ķ –Ľ–ł—Ü–Ķ—ā–ĺ –Ĺ–į –ĺ–Ī–Ķ–ļ—ā–į —Ā–Ķ –ľ–ĺ–ī–ł—Ą–ł—Ü–ł—Ä–į, –∑–į –ī–į —Ā–Ķ —Ā—ä–∑–ī–į–ī–į—ā —É–Ī–Ķ–ī–ł—ā–Ķ–Ľ–Ĺ–ĺ —Ä–Ķ–į–Ľ–ł—Ā—ā–ł—á–Ĺ–ł –ļ–į–ī—Ä–ł –ĺ—ā —Ā—ä–Ī–ł—ā–ł—Ź, –ļ–ĺ–ł—ā–ĺ –≤—Ā—ä—Č–Ĺ–ĺ—Ā—ā –Ĺ–ł–ļ–ĺ–≥–į –Ĺ–Ķ —Ā–į —Ā–Ķ —Ā–Ľ—É—á–≤–į–Ľ–ł. –í —Ä–Ķ–∑—É–Ľ—ā–į—ā –Ĺ–į —ā–ĺ–≤–į —ā–ł–Ņ–ł—á–Ĺ–ł—ā–Ķ¬†–ī–ł–Ļ–Ņ—Ą–Ķ–Ļ–ļ –ī–Ķ—ā–Ķ–ļ—ā–ĺ—Ä–ł —Ā–Ķ —Ą–ĺ–ļ—É—Ā–ł—Ä–į—ā –≤—ä—Ä—Ö—É –Ľ–ł—Ü–Ķ—ā–ĺ –≤—ä–≤ –≤–ł–ī–Ķ–ĺ–ļ–Ľ–ł–Ņ–ĺ–≤–Ķ—ā–Ķ: –Ņ—ä—Ä–≤–ĺ –≥–ĺ –Ņ—Ä–ĺ—Ā–Ľ–Ķ–ī—Ź–≤–į—ā –ł —Ā–Ľ–Ķ–ī —ā–ĺ–≤–į –Ņ—Ä–Ķ–ī–į–≤–į—ā –ī–į–Ĺ–Ĺ–ł—ā–Ķ –∑–į –ł–∑—Ä—Ź–∑–į–Ĺ–ĺ—ā–ĺ –Ľ–ł—Ü–Ķ –Ĺ–į –Ĺ–Ķ–≤—Ä–ĺ–Ĺ–Ĺ–į –ľ—Ä–Ķ–∂–į, –ļ–ĺ—Ź—ā–ĺ –ĺ–Ņ—Ä–Ķ–ī–Ķ–Ľ—Ź –ī–į–Ľ–ł –Ķ –ł—Ā—ā–ł–Ĺ—Ā–ļ–ĺ –ł–Ľ–ł —Ą–į–Ľ—ą–ł–≤–ĺ. –Ě–į–Ņ—Ä–ł–ľ–Ķ—Ä, –Ņ—Ä–ł–ľ–ł–≥–≤–į–Ĺ–Ķ—ā–ĺ –Ĺ–į –ĺ—á–ł—ā–Ķ –Ĺ–Ķ —Ā–Ķ –≤—ä–∑–Ņ—Ä–ĺ–ł–∑–≤–Ķ–∂–ī–į –ī–ĺ–Ī—Ä–Ķ –≤—ä–≤ –≤–ł–ī–Ķ–ĺ —Ą–į–Ľ—ą–ł—Ą–ł–ļ–į—ā–ł—ā–Ķ, —ā–į–ļ–į —á–Ķ –ī–Ķ—ā–Ķ–ļ—ā–ĺ—Ä–ł—ā–Ķ —Ā–Ķ —Ą–ĺ–ļ—É—Ā–ł—Ä–į—ā –≤—ä—Ä—Ö—É –ī–≤–ł–∂–Ķ–Ĺ–ł—Ź—ā–į –Ĺ–į –ĺ—á–ł—ā–Ķ –ļ–į—ā–ĺ –Ķ–ī–ł–Ĺ –ĺ—ā –Ĺ–į—á–ł–Ĺ–ł—ā–Ķ –∑–į –ł–ī–Ķ–Ĺ—ā–ł—Ą–ł—Ü–ł—Ä–į–Ĺ–Ķ –Ĺ–į –ī–ł–Ļ–Ņ—Ą–Ķ–Ļ–ļ–ĺ–≤–Ķ—ā–Ķ. –°—ä–≤—Ä–Ķ–ľ–Ķ–Ĺ–Ĺ–ł—ā–Ķ –ī–Ķ—ā–Ķ–ļ—ā–ĺ—Ä–ł —Ä–į–∑—á–ł—ā–į—ā –Ĺ–į –ľ–ĺ–ī–Ķ–Ľ–ł –∑–į –ľ–į—ą–ł–Ĺ–Ĺ–ĺ –ĺ–Ī—É—á–Ķ–Ĺ–ł–Ķ –∑–į –ł–ī–Ķ–Ĺ—ā–ł—Ą–ł—Ü–ł—Ä–į–Ĺ–Ķ –Ĺ–į —Ą–į–Ľ—ą–ł–≤–ł—ā–Ķ –≤–ł–ī–Ķ–ĺ–ļ–Ľ–ł–Ņ–ĺ–≤–Ķ.

–í–į–∂–Ĺ–ĺ—ā–ĺ –Ķ, —á–Ķ "–ł–∑–ľ–į–ľ–į—ā–į" —Ä–į–Ī–ĺ—ā–ł –Ņ—Ä–ł –Ņ—Ä–Ķ–ļ–ĺ–ī–ł—Ä–į–Ĺ–Ķ –ł —Ā—Ä–Ķ—ȗɬ†–ľ–Ĺ–ĺ–≥–ĺ –ĺ—ā –Ĺ–į–Ļ-—Ā—ä–≤—ä—Ä—ą–Ķ–Ĺ–ł—ā–Ķ –ī–Ķ—ā–Ķ–ļ—ā–ĺ—Ä–ł. –í—Ā—ä—Č–Ĺ–ĺ—Ā—ā –Ķ–ļ—Ā–Ņ–Ķ—Ä—ā–ł—ā–Ķ –∑–į–ļ–Ľ—é—á–į–≤–į—ā, —á–Ķ –Ņ–ĺ—Ä–į–ī–ł –ĺ—Ā–ĺ–Ī–Ķ–Ĺ–ĺ—Ā—ā–ł—ā–Ķ –Ĺ–į –į–Ľ–≥–ĺ—Ä–ł—ā–ľ–ł—ā–Ķ, –ļ–ĺ–ł—ā–ĺ –ĺ—ā–ļ—Ä–ł–≤–į—ā —Ą–į–Ľ—ą–ł—Ą–ł–ļ–į—ā–ł—ā–Ķ, –Ĺ–į–ł—Ā—ā–ł–Ĺ–į –Ķ –Ľ–Ķ—Ā–Ĺ–ĺ –ī–į —Ā–Ķ –ł–∑–ľ–į–ľ—Ź—ā –≤—Ā–ł—á–ļ–ł.

‚Äě–°–ľ—Ź—ā–į–ľ–Ķ, —á–Ķ –∑–į –ī–į –ł–∑–Ņ–ĺ–Ľ–∑–≤–į–ľ–Ķ —ā–Ķ–∑–ł –ī–ł–Ļ–Ņ—Ą–Ķ–Ļ–ļ –ī–Ķ—ā–Ķ–ļ—ā–ĺ—Ä–ł –Ĺ–į –Ņ—Ä–į–ļ—ā–ł–ļ–į, –Ķ –ĺ—ā —Ā—ä—Č–Ķ—Ā—ā–≤–Ķ–Ĺ–ĺ –∑–Ĺ–į—á–Ķ–Ĺ–ł–Ķ –ī–į –≥–ł –ĺ—Ü–Ķ–Ĺ–ł–ľ —Ā–Ņ—Ä—Ź–ľ–ĺ –į–ī–į–Ņ—ā–ł–≤–Ĺ–ł—Ź –Ņ—Ä–ĺ—ā–ł–≤–Ĺ–ł–ļ, –ļ–ĺ–Ļ—ā–ĺ –Ķ –Ĺ–į—Ź—Ā–Ĺ–ĺ —Ā —ā–Ķ–∑–ł –∑–į—Č–ł—ā–ł –ł —É–ľ–ł—ą–Ľ–Ķ–Ĺ–ĺ —Ā–Ķ –ĺ–Ņ–ł—ā–≤–į –ī–į –Ņ—Ä–Ķ–ī–ĺ—ā–≤—Ä–į—ā–ł —ā–Ķ–∑–ł –∑–į—Č–ł—ā–ł‚Äú, –Ņ–ł—ą–į—ā –ł–∑—Ā–Ľ–Ķ–ī–ĺ–≤–į—ā–Ķ–Ľ–ł—ā–Ķ. ‚Äě–°—ä–≤—Ä–Ķ–ľ–Ķ–Ĺ–Ĺ–ł—ā–Ķ –ľ–Ķ—ā–ĺ–ī–ł –∑–į –ĺ—ā–ļ—Ä–ł–≤–į–Ĺ–Ķ –Ĺ–į —Ą–į–Ľ—ą–ł–≤–ł —Ą–į–Ľ—ą–ł—Ą–ł–ļ–į—ā–ł –ľ–ĺ–≥–į—ā –Ľ–Ķ—Ā–Ĺ–ĺ –ī–į –Ī—ä–ī–į—ā –∑–į–ĺ–Ī–ł–ļ–ĺ–Ľ–Ķ–Ĺ–ł, –į–ļ–ĺ –Ņ—Ä–ĺ—ā–ł–≤–Ĺ–ł–ļ—ä—ā –ł–ľ–į –Ņ—ä–Ľ–Ĺ–ł –ł–Ľ–ł –ī–ĺ—Ä–ł —á–į—Ā—ā–ł—á–Ĺ–ł –Ņ–ĺ–∑–Ĺ–į–Ĺ–ł—Ź –∑–į –ī–Ķ—ā–Ķ–ļ—ā–ĺ—Ä–į‚Äú.

–ó–į –ī–į –Ņ–ĺ–ī–ĺ–Ī—Ä—Ź—ā –ī–Ķ—ā–Ķ–ļ—ā–ĺ—Ä–ł—ā–Ķ, –ł–∑—Ā–Ľ–Ķ–ī–ĺ–≤–į—ā–Ķ–Ľ–ł—ā–Ķ –Ņ—Ä–Ķ–Ņ–ĺ—Ä—ä—á–≤–į—ā –Ņ–ĺ–ī—Ö–ĺ–ī, –Ņ–ĺ–ī–ĺ–Ī–Ķ–Ĺ –Ĺ–į —ā–ĺ–∑–ł, –ł–∑–≤–Ķ—Ā—ā–Ķ–Ĺ –ļ–į—ā–ĺ –ļ–ĺ–Ĺ–ļ—É—Ä–Ķ–Ĺ—ā–Ĺ–ĺ –ĺ–Ī—É—á–Ķ–Ĺ–ł–Ķ¬†(adversarial training) - –ļ–į—ā–ĺ –Ņ–ĺ –≤—Ä–Ķ–ľ–Ķ –Ĺ–į –ĺ–Ī—É—á–Ķ–Ĺ–ł–Ķ –į–ī–į–Ņ—ā–ł–≤–Ĺ–ł—Ź—ā –Ņ—Ä–ĺ—ā–ł–≤–Ĺ–ł–ļ –Ņ—Ä–ĺ–ī—ä–Ľ–∂–į–≤–į –ī–į –≥–Ķ–Ĺ–Ķ—Ä–ł—Ä–į –Ĺ–ĺ–≤–ł –ī–ł–Ļ–Ņ—Ą–Ķ–Ļ–ļ–ĺ–≤–Ķ, –ļ–ĺ–ł—ā–ĺ –ľ–ĺ–≥–į—ā –ī–į –∑–į–ĺ–Ī–ł–ļ–ĺ–Ľ—Ź—ā —ā–Ķ–ļ—É—Č–ĺ—ā–ĺ —Ā—ä—Ā—ā–ĺ—Ź–Ĺ–ł–Ķ –Ĺ–į –ī–Ķ—ā–Ķ–ļ—ā–ĺ—Ä–į, –į–ł –ī–Ķ—ā–Ķ–ļ—ā–ĺ—Ä—ä—ā –Ņ—Ä–ĺ–ī—ä–Ľ–∂–į–≤–į –ī–į —Ā–Ķ —É—Ā—ä–≤—ä—Ä—ą–Ķ–Ĺ—Ā—ā–≤–į, –∑–į –ī–į –ĺ—ā–ļ—Ä–ł–Ķ –Ĺ–ĺ–≤–ł—ā–Ķ –ī–ł–Ļ–Ņ—Ą–Ķ–Ļ–ļ–ĺ–≤–Ķ.

–ü–ĺ–ī–ĺ–Ī–Ĺ–ł —Ä–į–∑—Ä–į–Ī–ĺ—ā–ļ–ł –ľ–ĺ–≥–į—ā –ī–į —Ā—ā–į–Ĺ–į—ā –ľ–Ĺ–ĺ–≥–ĺ –Ņ–ĺ-—Ā—ä–≤—ä—Ä—ą–Ķ–Ĺ–ł, –ļ–ĺ–Ķ—ā–ĺ –ĺ—ā–Ĺ–ĺ–≤–ĺ –Ņ–ĺ—Ā—ā–į–≤—Ź –Ņ–ĺ–ī —Ā—ä–ľ–Ĺ–Ķ–Ĺ–ł–Ķ —Ā–į–ľ–į—ā–į –ļ–ĺ–Ĺ—Ü–Ķ–Ņ—Ü–ł—Ź –∑–į –ī–ĺ–≤–Ķ—Ä–ł–Ķ –≤—ä–≤ –≤–ł–ī–Ķ–ĺ–ļ–Ľ–ł–Ņ–ĺ–≤–Ķ—ā–Ķ. –ü–ĺ-—ā–ĺ—á–Ĺ–ĺ, —ā–ĺ–≤–į –Ņ–ĺ—Ä–į–∂–ī–į –ĺ–Ņ–į—Ā–Ķ–Ĺ–ł—Ź, —á–Ķ –ľ–į–Ĺ–ł–Ņ—É–Ľ–ł—Ä–į–Ĺ–Ķ—ā–ĺ –Ĺ–į –ĺ–Ī—Č–Ķ—Ā—ā–≤–Ķ–Ĺ–ĺ—ā–ĺ –ľ–Ĺ–Ķ–Ĺ–ł–Ķ –ľ–ĺ–∂–Ķ –ī–į —Ā—ā–į–Ĺ–Ķ –ľ–Ĺ–ĺ–≥–ĺ –Ņ–ĺ-–Ľ–Ķ—Ā–Ĺ–ĺ –∑–į –Ĺ–Ķ–ī–ĺ–Ņ—Ä–ĺ—Ā—ä–≤–Ķ—Ā—ā–Ĺ–ł—ā–Ķ, –ĺ—ā–ļ–ĺ–Ľ–ļ–ĺ—ā–ĺ –∑–į –Ņ—Ä–į–≤–ĺ–Ņ—Ä–ł–Ľ–į–≥–į—Č–ł—ā–Ķ –ĺ—Ä–≥–į–Ĺ–ł –ł —Ā–į–ľ–ł—ā–Ķ —Ö–ĺ—Ä–į. –ė –į–ļ–ĺ –Ņ—ä—Ä–≤–ĺ–Ĺ–į—á–į–Ľ–Ĺ–ĺ –≤—ä–Ľ–Ĺ–į—ā–į¬†–ī–ł–Ļ–Ņ—Ą–Ķ–Ļ–ļ–ĺ–≤–Ķ —Ā–Ķ –≤—ä–∑–Ņ—Ä–ł–Ķ–ľ–į—ą–Ķ —Ā–į–ľ–ĺ –ļ–į—ā–ĺ –∑–į–Ī–į–≤–Ľ–Ķ–Ĺ–ł–Ķ, —ā–ĺ –ľ–į–Ľ–ļ–ĺ –Ņ–ĺ-–ļ—ä—Ā–Ĺ–ĺ –ĺ–Ņ–į—Ā–Ĺ–ĺ—Ā—ā—ā–į –ĺ—ā —ā–Ķ—Ö–Ĺ–ĺ–Ľ–ĺ–≥–ł–ł—ā–Ķ —Ā—ā–į–Ĺ–į –ĺ—á–Ķ–≤–ł–ī–Ĺ–į.

–•–ĺ—Ä–į—ā–į —Ā–į —Ā–≤–ł–ļ–Ĺ–į–Ľ–ł –ī–į —Ā–Ķ –ī–ĺ–≤–Ķ—Ä—Ź–≤–į—ā –Ĺ–į —ā–ĺ–≤–į, –ļ–ĺ–Ķ—ā–ĺ –≤–ł–∂–ī–į—ā —Ā –ĺ—á–ł—ā–Ķ —Ā–ł, –į –ī–ĺ–Ī—Ä–Ķ –Ĺ–į–Ņ—Ä–į–≤–Ķ–Ĺ–ł—Ź—ā¬†–ī–ł–Ļ–Ņ—Ą–Ķ–Ļ–ļ –ľ–ĺ–∂–Ķ –ī–į —Ā–Ķ —Ä–į–∑–Ľ–ł—á–ł –ĺ—ā –ł—Ā—ā–ł–Ĺ—Ā–ļ–ł –≤–ł–ī–Ķ–ĺ–ļ–Ľ–ł–Ņ. –ü–ĺ–Ĺ—Ź–ļ–ĺ–≥–į –Ķ –ī–ĺ—Ā—ā–į—ā—ä—á–Ĺ–ĺ –ī–ĺ—Ä–ł –ī–į –Ĺ–Ķ —Ā–Ķ –∑–į–ľ–Ķ–Ĺ—Ź –Ľ–ł—Ü–Ķ—ā–ĺ –Ĺ–į —á–ĺ–≤–Ķ–ļ–į, –į —Ā–į–ľ–ĺ –ī–į —Ā–Ķ —Ā–ł–Ĺ—Ö—Ä–ĺ–Ĺ–ł–∑–ł—Ä–į—ā –ī–≤–ł–∂–Ķ–Ĺ–ł—Ź—ā–į –Ĺ–į —É—Ā—ā–Ĺ–ł—ā–Ķ —Ā —Ą–į–Ľ—ą–ł–≤–į —Ä–Ķ—á. –ě–Ī—Ö–≤–į—ā—ä—ā –Ĺ–į –≤—ä–∑–ľ–ĺ–∂–Ĺ–ĺ—ā–ĺ –ł–∑–Ņ–ĺ–Ľ–∑–≤–į–Ĺ–Ķ –Ĺ–į –Ņ–ĺ–ī–ĺ–Ī–Ĺ–ł –ľ–į–Ĺ–ł–Ņ—É–Ľ–į—Ü–ł–ł –Ķ –Ĺ–į–ł—Ā—ā–ł–Ĺ–į –Ĺ–Ķ–ĺ–≥—Ä–į–Ĺ–ł—á–Ķ–Ĺ. –ź –ī–Ķ—ā–Ķ–ļ—ā–ĺ—Ä–ł –∑–į —ā–į–ļ–ł–≤–į —Ą–į–Ľ—ą–ł—Ą–ł–ļ–į—ā–ł —Ā–Ķ —Ä–į–∑—Ä–į–Ī–ĺ—ā–≤–į—ā –ĺ—ā —Ā—ā–ĺ—ā–ł—Ü–ł –Ķ–ļ–ł–Ņ–ł –Ņ–ĺ —Ü–Ķ–Ľ–ł—Ź —Ā–≤—Ź—ā.

–ė—Ā—ā–ĺ—á–Ĺ–ł–ļ:¬†Computer Scientists Create Fake Videos That Fool State-of-the-Art Deepfake Detectors,¬† SciTechDaily¬†

–ě—Č–Ķ –Ņ–ĺ —ā–Ķ–ľ–į—ā–į

–Ę–Ķ—Ö–Ĺ–ĺ–Ľ–ĺ–≥–ł–ł

‚Ä≥–°—ä–≤—Ā–Ķ–ľ –ł—Ā—ā–ł–Ĺ—Ā–ļ–ł—ā–Ķ‚ÄĚ –≤–ł–ī–Ķ–ĺ —Ą–į–Ľ—ą–ł—Ą–ł–ļ–į—ā–ł —Č–Ķ –ī–ĺ–Ļ–ī–į—ā —Ā–Ľ–Ķ–ī 1/2 –ī–ĺ 1 –≥–ĺ–ī–ł–Ĺ–į (–≤–ł–ī–Ķ–ĺ)

–ö–ĺ–ľ–Ķ–Ĺ—ā–į—Ä–ł

–ú–ĺ–Ľ—Ź, —Ä–Ķ–≥–ł—Ā—ā—Ä–ł—Ä–į–Ļ—ā–Ķ —Ā–Ķ –ĺ—ā T–£–ö!

–ź–ļ–ĺ –≤–Ķ—á–Ķ –ł–ľ–į—ā–Ķ —Ä–Ķ–≥–ł—Ā—ā—Ä–į—Ü–ł—Ź, –Ĺ–į—ā–ł—Ā–Ĺ–Ķ—ā–Ķ –Ę–£–ö!

–Ě—Ź–ľ–į –ļ–ĺ–ľ–Ķ–Ĺ—ā–į—Ä–ł –ļ—ä–ľ —ā–į–∑–ł –Ĺ–ĺ–≤–ł–Ĺ–į !

–ü–ĺ—Ā–Ľ–Ķ–ī–Ĺ–ł –ļ–ĺ–ľ–Ķ–Ĺ—ā–į—Ä–ł

Gunteer

–ü—Ä–Ķ—Ā—ā–ł–∂–Ĺ–į –Ĺ–į–≥—Ä–į–ī–į –ĺ—ā –Ď–ź–Ě —Ā–Ņ–Ķ—á–Ķ–Ľ–ł –≥–Ľ–į–≤–Ĺ–ł—Ź—ā —Ä–Ķ–ī–į–ļ—ā–ĺ—Ä –Ĺ–į –Ě–į—É–ļ–įOFFNews

–•—Ä–ł—Ā—ā–ł—Ź–Ĺ–ł–Ĺ

–Ę–ĺ–≤–į –Ķ –ļ—Ä–į–Ľ—Ź—ā –Ĺ–į —ā–ł–ļ–≤–ł—ā–Ķ: –Ę–ł–ļ–≤–į—ā–į –ľ—É —ā–Ķ–∂–ł –Ĺ–į–ī –Ķ–ī–ł–Ĺ –Ķ–ī–ł–Ĺ —ā–ĺ–Ĺ

dolivo

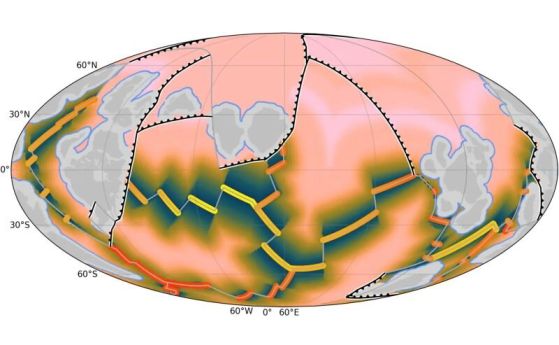

–°–į—Ö–į—Ä–į –ĺ—á–į–ļ–≤–į 75% —É–≤–Ķ–Ľ–ł—á–Ķ–Ĺ–ł–Ķ –Ĺ–į –≤–į–Ľ–Ķ–∂–ł—ā–Ķ –ī–ĺ 2100 –≥.

dolivo

–ó–Ķ–ľ–Ĺ–į—ā–į —Ź–Ī—ä–Ľ–ļ–į: —Ā—ā–į—Ä–į –ļ—É–Ľ—ā—É—Ä–į –∑–į –Ĺ–ĺ–≤–ł—ā–Ķ –ļ–Ľ–ł–ľ–į—ā–ł—á–Ĺ–ł –≤—Ä–Ķ–ľ–Ķ–Ĺ–į