–•–ĺ—Ä–į—ā–į –ĺ—ā–ī–į–≤–Ĺ–į¬†–ľ–Ķ—á—ā–į—Ź—ā –∑–į –≤—Ä–Ķ–ľ–Ķ—ā–ĺ, –ļ–ĺ–≥–į—ā–ĺ —Ä–ĺ–Ī–ĺ—ā–ł—ā–Ķ —Č–Ķ –Ĺ–ł –ĺ—Ā–≤–ĺ–Ī–ĺ–ī—Ź—ā –ĺ—ā –ľ–Ĺ–ĺ–≥–ĺ –∑–į–ī—ä–Ľ–∂–Ķ–Ĺ–ł—Ź, –Ĺ–ĺ –≤ —Ā—ä—Č–ĺ—ā–ĺ –≤—Ä–Ķ–ľ–Ķ, –Ĺ–į–≤–Ľ–ł–∑–į–Ĺ–Ķ—ā–ĺ –ł–ľ –≤ –∂–ł–≤–ĺ—ā–į –Ĺ–į —Ö–ĺ—Ä–į—ā–į –Ņ–ĺ—Ā—ā–į–≤—Ź¬†–≤—ä–Ņ—Ä–ĺ—Ā–į¬†–ī–į–Ľ–ł –ł –ļ–į–ļ —Č–Ķ –ľ–ĺ–∂–Ķ –ī–į —Ā–Ķ –Ĺ–į—É—á–į—ā –Ĺ–į –ľ–ĺ—Ä–į–Ľ –ł –Ķ—ā–ł–ļ–į.

–ė –į–ļ–ĺ –Ĺ–į –Ĺ—Ź–ļ–ĺ–ł –ľ–ĺ–∂–Ķ –ī–į –ł–ľ –ł–∑–≥–Ľ–Ķ–∂–ī–į—ā —ā–Ķ–∑–ł –≤—ä–Ņ—Ä–ĺ—Ā–ł —Ą–į–Ĺ—ā–į—Ā—ā–ł–ļ–į, —ā–ĺ —Č–Ķ –ł–ľ –Ņ—Ä–ł–Ņ–ĺ–ľ–Ĺ–ł–ľ, —á–Ķ –į–≤—ā–ĺ–Ĺ–ĺ–ľ–Ĺ–ł—ā–Ķ –į–≤—ā–ĺ–ľ–ĺ–Ī–ł–Ľ–ł –≤–Ķ—á–Ķ —Ā–Ķ –ī–≤–ł–∂–į—ā –Ņ–ĺ —É–Ľ–ł—Ü–ł—ā–Ķ –Ĺ–į –Ĺ—Ź–ļ–ĺ–ł –≥—Ä–į–ī–ĺ–≤–Ķ.

–Ē—Ä—É–≥–ł –Ī–ł—Ö–į –ļ–į–∑–į–Ľ–ł, —á–Ķ —ā—ä–Ļ –ļ–į—ā–ĺ —Ä–ĺ–Ī–ĺ—ā–ł—ā–Ķ —Ā–į –ľ–į—ą–ł–Ĺ–ł –Ķ –Ĺ–Ķ—É–ľ–Ķ—Ā—ā–Ĺ–ĺ –ī–į —Ā–Ķ –≥–ĺ–≤–ĺ—Ä–ł –∑–į "–ľ–ĺ—Ä–į–Ľ" , –į —Ā–į–ľ–ĺ –∑–į –Ņ—Ä–ĺ–≥—Ä–į–ľ–į –ł –Ņ—Ä–į–≤–ł–Ľ–į,¬†–∑–į–Ľ–ĺ–∂–Ķ–Ĺ–ł –Ņ—Ä–Ķ–ī–≤–į—Ä–ł—ā–Ķ–Ľ–Ĺ–ĺ —É —ā—Ź—Ö. –ö–ĺ–≥–į—ā–ĺ –Ņ—Ä–Ķ–∑ –ľ–į–Ļ —ā–į–∑–ł –≥–ĺ–ī–ł–Ĺ–į –≤ Brookings Institution, –ľ–ĺ–∑—ä—á–Ķ–Ĺ —ā—Ä—ä—Ā—ā –≤—ä–≤ –í–į—ą–ł–Ĺ–≥—ā–ĺ–Ĺ, —Ā–Ķ –ī–ł—Ā–ļ—É—ā–ł—Ä–į—ą–Ķ –ļ–į–ļ –į–≤—ā–ĺ–Ĺ–ĺ–ľ–Ĺ–ł—ā–Ķ¬†–Ņ—Ä–Ķ–≤–ĺ–∑–Ĺ–ł —Ā—Ä–Ķ–ī—Ā—ā–≤–į —Č–Ķ —Ā–Ķ –ī—ä—Ä–∂–į—ā –≤ —É—Ā–Ľ–ĺ–≤–ł—Ź—ā–į –Ĺ–į –ļ—Ä–ł–∑–į, –Ī–Ķ –ī–į–ī–Ķ–Ĺ —Ā–Ľ–Ķ–ī–Ĺ–ł—Ź –Ņ—Ä–ł–ľ–Ķ—Ä: –ö–į–ļ–≤–ĺ —Č–Ķ –Ĺ–į–Ņ—Ä–į–≤–ł —Ä–ĺ–Ī–ĺ—ā—ä—ā-–į–≤—ā–ĺ–ľ–ĺ–Ī–ł–Ľ, –į–ļ–ĺ —ā—Ä—Ź–Ī–≤–į –ī–į –ł–∑–Ī–ł—Ä–į –ī–į–Ľ–ł –ī–į —Ā–Ņ–į—Ā–ł —Ā–≤–ĺ–ł—ā–Ķ —Ā–ĺ–Ī—Ā—ā–≤–Ķ–Ĺ–ł –Ņ—ä—ā–Ĺ–ł—Ü–ł –ł –ī–į –Ĺ–į–Ī–ł–Ķ —Ā–Ņ–ł—Ä–į—á–ļ–ł, –Ĺ–ĺ —ā–ĺ–≤–į –ī–į –Ņ–ĺ–ī–Ľ–ĺ–∂–ł –Ĺ–į —Ä–ł—Ā–ļ –ł–ī–≤–į—Č–ł—ā–Ķ —Ā–Ľ–Ķ–ī –Ĺ–Ķ–≥–ĺ –Ņ—Ä–Ķ–≤–ĺ–∑–Ĺ–ł —Ā—Ä–Ķ–ī—Ā—ā–≤–į? –ė–Ľ–ł –ļ–į–ļ–≤–ĺ —Č–Ķ –Ĺ–į–Ņ—Ä–į–≤–ł, –į–ļ–ĺ –į–≤—ā–ĺ–Ĺ–ĺ–ľ–Ĺ–į—ā–į –ļ–ĺ–Ľ–į —ā—Ä—Ź–Ī–≤–į –ī–į –∑–į–≤–ł–Ķ —Ä—Ź–∑–ļ–ĺ, –∑–į –ī–į –ł–∑–Ī–Ķ–≥–Ĺ–Ķ –ī–Ķ—ā–Ķ, –Ĺ–ĺ —Ä–ł—Ā–ļ—É–≤–į –ī–į —É–ī–į—Ä–ł –Ĺ—Ź–ļ–ĺ–Ļ –ī—Ä—É–≥ –Ĺ–į–Ī–Ľ–ł–∑–ĺ?

–Ę–Ķ–∑–ł –ī–ł–Ľ–Ķ–ľ–ł –Ĺ–Ķ —Ā–į –Ľ–Ķ—Ā–Ĺ–ł –ł –∑–į —á–ĺ–≤–Ķ–ļ-–≤–ĺ–ī–į—á –ł —ā–ĺ–Ļ –Ī–ł –Ņ–ĺ—Ā—ā—ä–Ņ–ł–Ľ —Ā–Ņ–ĺ—Ä–Ķ–ī —Ā–ĺ–Ī—Ā—ā–≤–Ķ–Ĺ–ł—Ź —Ā–ł –ľ–ĺ—Ä–į–Ľ, –ļ–ĺ–Ļ—ā–ĺ —Ā—ä—Č–ĺ –Ķ –Ĺ–į–Ī–ĺ—Ä –ĺ—ā –Ņ—Ä–į–≤–ł–Ľ–į –ł –ļ–ĺ–ľ–į–Ĺ–ī–ł, –ļ–ĺ–ł—ā–ĺ –Ķ –≤—ä–∑–Ņ—Ä–ł–Ķ–ľ–į–Ľ¬†–ĺ—ā —Ä–į–Ĺ–Ĺ–ĺ –ī–Ķ—ā—Ā—ā–≤–ĺ, –ļ–ĺ–≥–į—ā–ĺ —Ā–Ķ –Ķ —É—á–ł–Ľ –Ĺ–į –≥—Ä–į–Ĺ–ł—Ü–ł—ā–Ķ –Ĺ–į –Ņ–ĺ–∑–≤–ĺ–Ľ–Ķ–Ĺ–ĺ—ā–ĺ –ł –Ņ—Ä–ł–Ķ–ľ–Ľ–ł–≤–ĺ—ā–ĺ –∑–į —Ā–≤–ĺ—Ź—ā–į —Ā—Ä–Ķ–ī–į.

–Ě—Ä–į–≤—Ā—ā–≤–Ķ–Ĺ–ĺ—ā–ĺ –ĺ–Ī—Ä–į–∑–ĺ–≤–į–Ĺ–ł–Ķ –Ĺ–į —Ö–ĺ—Ä–į—ā–į –ł —Ä–ĺ–Ī–ĺ—ā–ł—ā–Ķ

–ü—Ä–Ķ–ī–ł –≤—Ā–ł—á–ļ–嬆—ā—Ä—Ź–Ī–≤–į –ī–į —Ä–į–∑–Ī–Ķ—Ä–Ķ–ľ –ļ–į–ļ —Ā–į–ľ–ł—ā–Ķ —Ö–ĺ—Ä–į –Ņ—Ä–į–≤—Ź—ā —Ā–≤–ĺ–ł—ā–Ķ –ľ–ĺ—Ä–į–Ľ–Ĺ–ł –ł–∑–Ī–ĺ—Ä–ł –Ī–Ľ–į–≥–ĺ–ī–į—Ä–Ķ–Ĺ–ł–Ķ –Ĺ–į —É–Ĺ–ł–ļ–į–Ľ–Ĺ–į—ā–į —Ā–ł —Ā–Ņ–ĺ—Ā–ĺ–Ī–Ĺ–ĺ—Ā—ā –ī–į –≤—ä–∑–Ņ—Ä–ł–Ķ–ľ–į—ā —Ā–ĺ—Ü–ł–į–Ľ–Ĺ–ł –ł –Ķ—ā–ł—á–Ĺ–ł –Ĺ–ĺ—Ä–ľ–ł. –ź —Ā–Ľ–Ķ–ī —ā–ĺ–≤–į –ī–į —É–∑–Ĺ–į–Ķ–ľ –ī–į–Ľ–ł —Ä–ĺ–Ī–ĺ—ā–ł—ā–Ķ –ľ–ĺ–≥–į—ā –ī–į —Ä–į–∑–Ņ–ĺ–∑–Ĺ–į–≤–į—ā, —Ä–į–∑–Ī–ł—Ä–į—ā –ł –ĺ—ā–≥–ĺ–≤–į—Ä—Ź—ā –Ĺ–į —ā–Ķ–∑–ł —Ā—ā–į–Ĺ–ī–į—Ä—ā–ł.

–ö–į–ļ—ā–ĺ —Ä–ĺ–Ī–ĺ—ā–ł—ā–Ķ, —ā–į–ļ–į –ł —Ö–ĺ—Ä–į—ā–į –∑–į–Ņ–ĺ—á–≤–į—ā –∂–ł–≤–ĺ—ā–į —Ā–ł —Ā –Ņ—ä–Ľ–Ĺ–į –Ľ–ł–Ņ—Ā–į –Ĺ–į —Ä–į–∑–Ī–ł—Ä–į–Ĺ–Ķ –Ĺ–į —Ā–Ľ–ĺ–∂–Ĺ–ł—ā–Ķ –ł–∑–ł—Ā–ļ–≤–į–Ĺ–ł—Ź –Ĺ–į –ĺ–Ī—Č–Ķ—Ā—ā–≤–ĺ—ā–ĺ. –ú–į–Ľ–ļ–ł—ā–Ķ –ī–Ķ—Ü–į –Ņ–ĺ—Ā—ā–Ķ–Ņ–Ķ–Ĺ–Ĺ–ĺ —Ā–Ķ –Ĺ–į—É—á–į–≤–į—ā –Ĺ–į –Ņ—Ä–į–≤–ł–Ľ–į—ā–į –Ĺ–į —Ā–ĺ—Ü–ł–į–Ľ–Ĺ–ĺ—ā–ĺ –ĺ–Ī—Č—É–≤–į–Ĺ–Ķ –Ņ—ä—Ä–≤–ĺ –≤ —Ā–Ķ–ľ–Ķ–Ļ—Ā—ā–≤–ĺ—ā–ĺ, –į —Ā–Ľ–Ķ–ī —ā–ĺ–≤–į –Ņ—Ä–ł–Ľ–į–≥–į—ā —ā–Ķ–∑–ł –Ņ—Ä–į–≤–ł–Ľ–į –ł–∑–≤—ä–Ĺ –ī–ĺ–ľ–į. –í —É—á–ł–Ľ–ł—Č–Ĺ–į –≤—ä–∑—Ä–į—Ā—ā –ī–Ķ—Ü–į—ā–į –Ĺ–į—É—á–į–≤–į—ā –ĺ—Č–Ķ –ľ–Ĺ–ĺ–≥–ĺ –Ņ—Ä–į–≤–ł–Ľ–į, –Ĺ–ĺ –≤—Ā–Ķ –ĺ—Č–Ķ –Ĺ–Ķ —Ā–į –≥–ĺ—ā–ĺ–≤–ł –∑–į –ľ–Ĺ–ĺ–≥–ĺ —Ā–ł—ā—É–į—Ü–ł–ł –≤ —Ā–≤–Ķ—ā–į –Ĺ–į –≤—ä–∑—Ä–į—Ā—ā–Ĺ–ł—ā–Ķ. –Ē–ĺ—Ä–ł –≤—ä–∑—Ä–į—Ā—ā–Ĺ–ł –Ņ–ĺ—Ā—ā–ĺ—Ź–Ĺ–Ĺ–ĺ —Ā–Ķ —Ā–Ī–Ľ—ä—Ā–ļ–≤–į—ā —Ā –Ĺ–ĺ–≤–ł –Ņ—Ä–į–≤–ł–Ľ–į –≤ –Ĺ–Ķ–Ņ–ĺ–∑–Ĺ–į—ā–ł –∑–į–ī–į—á–ł, —Ā–ł—ā—É–į—Ü–ł–ł, —Ä–ĺ–Ľ–ł –ł –≤–∑–į–ł–ľ–ĺ–ĺ—ā–Ĺ–ĺ—ą–Ķ–Ĺ–ł—Ź.

–ö–į–ļ—ā–ĺ –Ĺ–į—É—á–į–≤–į–ľ–Ķ –≤—Ā–ł—á–ļ–ł —ā–Ķ–∑–ł –Ņ—Ä–į–≤–ł–Ľ–į –ł –Ĺ–ĺ—Ä–ľ–ł? –Ę–ĺ–≤–į –Ķ —Ā–Ľ–ĺ–∂–Ķ–Ĺ –ł —Ā–Ľ–į–Ī–ĺ –Ņ—Ä–ĺ—É—á–Ķ–Ĺ –Ņ—Ä–ĺ—Ü–Ķ—Ā, –Ĺ–ĺ –ł–ľ–į –ī–≤–į –ĺ—Ā–Ĺ–ĺ–≤–Ĺ–ł –ľ–Ķ—Ö–į–Ĺ–ł–∑–ľ–į. –ü—ä—Ä–≤–ł—Ź—ā —Ā–Ķ –Ņ—Ä–ĺ—Ź–≤—Ź–≤–į –≤ –Ĺ–į–Ļ-—Ä–į–Ĺ–Ĺ–ł—ā–Ķ –Ķ—ā–į–Ņ–ł –ĺ—ā –∂–ł–≤–ĺ—ā–į, –ļ–ĺ–≥–į—ā–ĺ –Ī–Ķ–Ī–Ķ—ā–į—ā–į –ĺ—ā–ļ—Ä–ł–≤–į—ā —Ā—ā–į—ā–ł—Ā—ā–ł—á–Ķ—Ā–ļ–ł –∑–į–ļ–ĺ–Ĺ–ĺ–ľ–Ķ—Ä–Ĺ–ĺ—Ā—ā–ł –≤—ä–≤ —Ą–ł–∑–ł—á–Ķ—Ā–ļ–ł—Ź –ł —Ā–ĺ—Ü–ł–į–Ľ–Ĺ–ł—Ź —Ā–≤—Ź—ā. –Ę–Ķ –∑–į–Ņ–ĺ—á–≤–į—ā –ī–į –ĺ—Ā–ľ–ł—Ā–Ľ—Ź—ā —ą–į–Ī–Ľ–ĺ–Ĺ–ł—ā–Ķ –≤ –Ņ–ĺ–≤–Ķ–ī–Ķ–Ĺ–ł–Ķ—ā–ĺ –Ĺ–į —Ö–ĺ—Ä–į—ā–į, —Ä–Ķ–į–≥–ł—Ä–į—Č–ł –Ĺ–į —Ä–į–∑–Ľ–ł—á–Ĺ–ł —Ā–ł—ā—É–į—Ü–ł–ł, –ĺ—Ā–ĺ–Ī–Ķ–Ĺ–ĺ –į–ļ–ĺ —ā–Ķ–∑–ł –ľ–ĺ–ī–Ķ–Ľ–ł —Ā–Ķ –Ņ–ĺ–≤—ā–į—Ä—Ź—ā –≤—ä–≤ —Ą–ĺ—Ä–ľ–į—ā–į –Ĺ–į –Ķ–∂–Ķ–ī–Ĺ–Ķ–≤–Ĺ–ł —Ä–ł—ā—É–į–Ľ–ł.

–ü–ĺ–Ľ—É—á–į–≤–į–Ļ–ļ–ł –Ņ—Ä–Ķ–ī—Ā—ā–į–≤–į –∑–į –Ĺ–ĺ—Ä–ľ–į—ā–į, –ī–Ķ—Ü–į—ā–į –ľ–ĺ–≥–į—ā —Ā–Ľ–Ķ–ī —ā–ĺ–≤–į –ī–į –ĺ—ā–ļ—Ä–ł–≤–į—ā —á—É–∂–ī–ł –ł–Ľ–ł –ī–į –ł–∑–≤—ä—Ä—ą–≤–į—ā —Ā–≤–ĺ–ł –Ĺ–į—Ä—É—ą–Ķ–Ĺ–ł—Ź –≤ —Ā—ā–į–Ĺ–ī–į—Ä—ā–Ĺ–ł—ā–Ķ —ą–į–Ī–Ľ–ĺ–Ĺ–ł –ł –ī–į –Ĺ–į–Ī–Ľ—é–ī–į–≤–į—ā —Ä–Ķ–į–ļ—Ü–ł—Ź—ā–į –Ĺ–į —Ö–ĺ—Ä–į—ā–į –≤ –ĺ—ā–≥–ĺ–≤–ĺ—Ä –Ĺ–į –Ĺ–į—Ä—É—ą–Ķ–Ĺ–ł–Ķ—ā–ĺ. –ě—ā–Ī–Ķ–Ľ—Ź–∑–≤–į–Ļ–ļ–ł —Ā—ā–Ķ–Ņ–Ķ–Ĺ—ā–į –Ĺ–į —Ä–Ķ–į–ļ—Ü–ł—Ź, —ā–Ķ —Ā–Ķ –Ĺ–į—É—á–į–≤–į—ā –ī–į –Ņ—Ä–į–≤—Ź—ā —Ä–į–∑–≥—Ä–į–Ĺ–ł—á–Ķ–Ĺ–ł–Ķ –ľ–Ķ–∂–ī—É —Ā—ā—Ä–ĺ–≥–ł—ā–Ķ –Ņ—Ä–į–≤–ł–Ľ–į (–Ņ—Ä–ł —Ā–ł–Ľ–Ĺ–į —Ä–Ķ–į–ļ—Ü–ł—Ź) –ĺ—ā –Ľ–Ķ–ļ–į –ł–Ľ–ł –Ĺ–ł–ļ–į–ļ–≤–į —Ä–Ķ–į–ļ—Ü–ł—Ź –Ņ—Ä–ł –ī–Ķ–Ļ—Ā—ā–≤–ł—Ź, –ĺ—ā –ļ–ĺ–ł—ā–ĺ –ľ–ĺ–∂–Ķ –ī–į –Ņ–ĺ–Ľ—É—á–į—ā –ł–∑–≥–ĺ–ī–į.

–Ě–ĺ –ľ–Ĺ–ĺ–≥–ĺ —Ā–ĺ—Ü–ł–į–Ľ–Ĺ–ł –ł –ľ–ĺ—Ä–į–Ľ–Ĺ–ł –Ĺ–ĺ—Ä–ľ–ł –Ĺ–Ķ –ľ–ĺ–∂–Ķ –Ņ—Ä–ĺ—Ā—ā–ĺ –ī–į —Ā–Ķ –Ĺ–į—É—á–į—ā –ļ–į—ā–ĺ —Ā–Ķ –Ņ—Ä–ĺ—Ā–Ľ–Ķ–ī—Ź–≤–į—ā –ľ–ĺ–ī–Ķ–Ľ–ł. –Ě–į–Ņ—Ä–ł–ľ–Ķ—Ä, –į–ļ–ĺ –∑–į–ļ–ĺ–Ĺ–ĺ–ľ–Ķ—Ä–Ĺ–ĺ—Ā—ā—ā–į —Ā–Ķ –ł–∑—Ä–į–∑—Ź–≤–į —Ā –Ľ–ł–Ņ—Ā–į—ā–į –Ĺ–į –ĺ–Ņ—Ä–Ķ–ī–Ķ–Ľ–Ķ–Ŗ嬆–Ņ–ĺ–≤–Ķ–ī–Ķ–Ĺ–ł–Ķ¬†–ł–Ľ–ł –į–ļ–ĺ –Ĺ–ł–ļ–ĺ–≥–į –Ĺ–Ķ —Ā—ā–Ķ –Ņ–ĺ–Ņ–į–ī–į–Ľ–ł –≤ —Ā–ł—ā—É–į—Ü–ł—Ź—ā–į, –≤ –ļ–ĺ—Ź—ā–ĺ —Ā–Ķ –Ņ—Ä–ł–Ľ–į–≥–į —Ā—ä–ĺ—ā–≤–Ķ—ā–Ĺ–ĺ—ā–ĺ –Ņ—Ä–į–≤–ł–Ľ–ĺ.

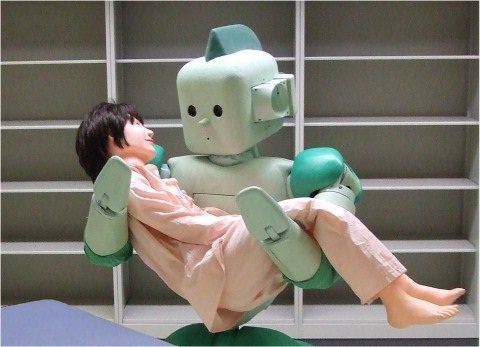

–†–ĺ–Ī–ĺ—ā—ä—ā RI-MAN, —Ä–į–∑—Ä–į–Ī–ĺ—ā–Ķ–Ĺ –ĺ—ā –ł–∑—Ā–Ľ–Ķ–ī–ĺ–≤–į—ā–Ķ–Ľ–ł –ĺ—ā¬†–ė–Ĺ—Ā—ā–ł—ā—É—ā–į RIKEN, –Į–Ņ–ĺ–Ĺ–ł—Ź, –Ķ –Ņ—Ä–Ķ–ī–Ĺ–į–∑–Ĺ–į—á–Ķ–Ĺ –ī–į —Ā–Ķ –≥—Ä–ł–∂–ł –∑–į —Ö–ĺ—Ä–į. –ė–∑–ĺ–Ī—Ä–į–∂–Ķ–Ĺ–ł–Ķ: RIKEN, Bio-Mimetic Control Research Center

–†–ĺ–Ī–ĺ—ā—ä—ā RI-MAN, —Ä–į–∑—Ä–į–Ī–ĺ—ā–Ķ–Ĺ –ĺ—ā –ł–∑—Ā–Ľ–Ķ–ī–ĺ–≤–į—ā–Ķ–Ľ–ł –ĺ—ā¬†–ė–Ĺ—Ā—ā–ł—ā—É—ā–į RIKEN, –Į–Ņ–ĺ–Ĺ–ł—Ź, –Ķ –Ņ—Ä–Ķ–ī–Ĺ–į–∑–Ĺ–į—á–Ķ–Ĺ –ī–į —Ā–Ķ –≥—Ä–ł–∂–ł –∑–į —Ö–ĺ—Ä–į. –ė–∑–ĺ–Ī—Ä–į–∂–Ķ–Ĺ–ł–Ķ: RIKEN, Bio-Mimetic Control Research Center

–í—ā–ĺ—Ä–ł—Ź—ā –ľ–Ķ—Ö–į–Ĺ–ł–∑—ä–ľ¬†—Ā–Ķ –ł–∑—Ä–į–∑—Ź–≤–į –≤¬†–Ņ—Ä–Ķ–Ņ–ĺ–ī–į–≤–į–Ĺ–Ķ –Ĺ–į –Ņ—Ä–į–≤–ł–Ľ–į—ā–į –ł –Ĺ–ĺ—Ä–ľ–ł—ā–Ķ –Ņ–ĺ –ī—Ä—É–≥–ł –Ĺ–į—á–ł–Ĺ–ł, –ļ–ĺ–ł—ā–ĺ –≤–į—Ä–ł—Ä–į—ā –ĺ—ā –ī–Ķ–ľ–ĺ–Ĺ—Ā—ā—Ä–į—Ü–ł—Ź –ī–ĺ —Ź–≤–Ĺ–ł –ł–∑–ł—Ā–ļ–≤–į–Ĺ–ł—Ź. –Ę–į–ļ–į –ī–Ķ—Ü–į—ā–į –ł –≤—ä–∑—Ä–į—Ā—ā–Ĺ–ł—ā–Ķ —Ā–į –≥–ĺ—ā–ĺ–≤–ł –ī–į –ī–Ķ–Ļ—Ā—ā–≤–į—ā "–ļ–į–ļ—ā–ĺ –ł–ľ —Ā–Ķ –ļ–į–∑–≤–į" –Ņ–ĺ—Ä–į–ī–ł —Ā–ł–Ľ–Ĺ–į—ā–į –∑–į–≤–ł—Ā–ł–ľ–ĺ—Ā—ā –ĺ—ā –ľ–Ĺ–Ķ–Ĺ–ł–Ķ—ā–ĺ –Ĺ–į –ī—Ä—É–≥–ł—ā–Ķ –ł —á—É–≤—Ā—ā–≤–ł—ā–Ķ–Ľ–Ĺ–ĺ—Ā—ā –ļ—ä–ľ –Ĺ–Ķ–ĺ–ī–ĺ–Ī—Ä–Ķ–Ĺ–ł–Ķ.

–ú–ĺ–∂–Ķ –Ľ–ł –ī–į —Ā–Ķ –Ņ—Ä–ł–Ľ–ĺ–∂–į—ā —ā–Ķ–∑–ł –ī–≤–į –ľ–Ķ—Ö–į–Ĺ–ł–∑–ľ–į –Ņ—Ä–ł —Ä–ĺ–Ī–ĺ—ā–ł—ā–Ķ, —ā–į–ļ–į —á–Ķ –ī–į —É—Ā–≤–ĺ—Ź—ā –Ņ—Ä–į–≤–ł–Ľ–į—ā–į –ļ–į–ļ—ā–ĺ —Ö–ĺ—Ä–į—ā–į? –í—Ā—ä—Č–Ĺ–ĺ—Ā—ā¬†–Ņ–ĺ–≤–Ķ–ī–Ķ–Ĺ—á–Ķ—Ā–ļ–ł—ā–Ķ –ľ–ĺ–ī–Ķ–Ľ–ł –Ľ–Ķ—Ā–Ĺ–ĺ –ľ–ĺ–≥–į—ā –ī–į —Ā–Ķ –Ņ—Ä–Ķ–ī—Ā—ā–į–≤—Ź—ā –ī–ł–≥–ł—ā–į–Ľ–Ĺ–ĺ, –Ĺ–ĺ –ĺ—Ü–Ķ–Ĺ–ļ–į—ā–į –Ĺ–į —Ā–ł–Ľ–į—ā–į –Ĺ–į —Ä–Ķ–į–ļ—Ü–ł–ł—ā–Ķ –Ņ—Ä–ł –Ĺ–į—Ä—É—ą–Ķ–Ĺ–ł–Ķ –Ĺ–į –Ņ—Ä–į–≤–ł–Ľ–į—ā–į –Ķ –Ņ–ĺ-—Ā–Ľ–ĺ–∂–Ķ–Ĺ –Ņ—Ä–ĺ–Ī–Ľ–Ķ–ľ.

–†–ĺ–Ī–ĺ—ā–ł—ā–Ķ –Ĺ–Ķ –ľ–ĺ–≥–į—ā –ī–į –Ī—ä–ī–į—ā –≤—ä–∑–Ņ–ł—ā–į–≤–į–Ĺ–ł –≤ –Ņ—Ä–ĺ–ī—ä–Ľ–∂–Ķ–Ĺ–ł–Ķ –Ĺ–į –≥–ĺ–ī–ł–Ĺ–ł –≤ —Ā–Ķ–ľ–Ķ–Ļ—Ā—ā–≤–ĺ –ļ–į—ā–ĺ –ī–Ķ—Ü–į—ā–į, —ā–į–ļ–į —á–Ķ –Ķ–ī–ł–Ĺ—Ā—ā–≤–Ķ–Ĺ–ł—Ź—ā –≤—ä–∑–ľ–ĺ–∂–Ķ–Ĺ –≤–į—Ä–ł–į–Ĺ—ā –Ķ –ī–į¬†–≥–ł –∑–į—Ö—Ä–į–Ĺ–≤–į–ľ–Ķ —Ą–ł–Ľ–ľ–ł –ł —ā–Ķ–Ľ–Ķ–≤–ł–∑–ł–ĺ–Ĺ–Ĺ–ł –Ņ—Ä–Ķ–ī–į–≤–į–Ĺ–ł—Ź. –†–ĺ–Ī–ĺ—ā—ä—ā –≥–Ľ–Ķ–ī–į–Ļ–ļ–ł –≤–ł–ī–Ķ–ĺ—ā–ĺ, –ľ–ĺ–∂–Ķ –ī–į —Ā—ä–Ī–Ķ—Ä–Ķ –≥–ĺ–Ľ—Ź–ľ–ĺ –ļ–ĺ–Ľ–ł—á–Ķ—Ā—ā–≤–ĺ –Ņ–ĺ–≤–Ķ–ī–Ķ–Ĺ—á–Ķ—Ā–ļ–ł —ą–į–Ī–Ľ–ĺ–Ĺ–ł, –ĺ—ā–ļ–Ľ–ĺ–Ĺ–Ķ–Ĺ–ł—Ź –ł —Ä–Ķ–į–ļ—Ü–ł–ł –Ĺ–į –ĺ—ā–ļ–Ľ–ĺ–Ĺ–Ķ–Ĺ–ł—Ź—ā–į. –í —ā–ĺ–∑–ł —Ā–Ľ—É—á–į–Ļ –ľ–Ĺ–ĺ–≥–ĺ –≤–į–∂–Ĺ–į —Ä–ĺ–Ľ—Ź –ł–≥—Ä–į–Ķ –ł–∑–Ī–ĺ—Ä—ä—ā –Ĺ–į –Ņ—Ä–į–≤–ł–Ľ–Ĺ–ł—ā–Ķ –ľ–į—ā–Ķ—Ä–ł–į–Ľ–ł –∑–į –ĺ–Ī—É—á–Ķ–Ĺ–ł–Ķ. –Į—Ā–Ĺ–ĺ –Ķ, —á–Ķ¬†–Ķ–ļ—ą—ä–Ĺ–ł –Ĺ–Ķ –≤—ä—Ä—ą–į—ā —Ä–į–Ī–ĺ—ā–į.

–ź–≥–Ķ–Ĺ—Ü–ł—Ź—ā–į –ļ—ä–ľ –ú–ł–Ĺ–ł—Ā—ā–Ķ—Ä—Ā—ā–≤–ĺ –Ĺ–į –ĺ—ā–Ī—Ä–į–Ĺ–į—ā–į –Ĺ–į –°–ź–©, –∑–į–Ĺ–ł–ľ–į–≤–į—Č–į —Ā–Ķ —Ā —Ä–į–∑–≤–ł—ā–ł–Ķ –Ĺ–į –Ĺ–ĺ–≤–ł—ā–Ķ —ā–Ķ—Ö–Ĺ–ĺ–Ľ–ĺ–≥–ł–ł, DARPA (Defense Advanced Research Projects Agency) —Ä–į–∑—Ä–į–Ī–ĺ—ā–≤–į –Ņ—Ä–ĺ–≥—Ä–į–ľ–į—ā–į "Mind‚Äôs Eye", –Ņ—Ä–Ķ–ī–Ĺ–į–∑–Ĺ–į—á–Ķ–Ĺ–į –∑–į –ļ–į–ľ–Ķ—Ä–ł —Ā "–≤–ł–∑—É–į–Ľ–Ĺ–į –ł–Ĺ—ā–Ķ–Ľ–ł–≥–Ķ–Ĺ—ā–Ĺ–ĺ—Ā—ā". –Ę–Ķ–∑–ł "—É–ľ–Ĺ–ł" –ļ–į–ľ–Ķ—Ä–ł –∑–į –Ĺ–į–Ī–Ľ—é–ī–Ķ–Ĺ–ł–Ķ –Ĺ–Ķ —Ā–į–ľ–ĺ "–≤–ł–∂–ī–į—ā", –Ĺ–ĺ —Ā—ä—Č–ĺ –ł —Ä–į–∑–Ī–ł—Ä–į—ā –ļ–į–ļ–≤–ĺ —Ā–Ķ —Ā–Ľ—É—á–≤–į –≤ –ľ–ĺ–ľ–Ķ–Ĺ—ā–į –ł –ī–ĺ—Ä–ł –ľ–ĺ–≥–į—ā –ī–į –Ņ—Ä–Ķ–ī—Ā–ļ–į–∑–≤–į—ā –ļ–į–ļ–≤–ĺ —Č–Ķ —Ā–Ķ —Ā–Ľ—É—á–ł –Ņ–ĺ-–Ĺ–į—ā–į—ā—ä–ļ.

–í—ā–ĺ—Ä–ł—Ź—ā –ľ–Ķ—Ö–į–Ĺ–ł–∑—ä–ľ –∑–į –ĺ–Ī—É—á–Ķ–Ĺ–ł–Ķ –Ņ–ĺ –Ņ—Ä–ł–Ĺ—Ü–ł–Ņ —Ā—ä—Č–ĺ –Ķ –Ľ–Ķ—Ā–Ķ–Ĺ –∑–į —É—Ā–≤–ĺ—Ź–≤–į–Ĺ–Ķ - –Ņ—Ä–ĺ—Ā—ā–ĺ –Ĺ–į —Ä–ĺ–Ī–ĺ—ā–ł—ā–Ķ —Ā–Ķ –Ņ–ĺ–ļ–į–∑–≤–į –ł –ĺ–Ī—Ź—Ā–Ĺ—Ź–≤–į –ļ–į–ļ–≤–ĺ –ľ–ĺ–∂–Ķ –ī–į –Ņ—Ä–į–≤—Ź—ā –ł –ļ–į–ļ–≤–ĺ –Ĺ–Ķ –ľ–ĺ–∂–Ķ –ī–į –Ņ—Ä–į–≤—Ź—ā. –Ę–ĺ–∑–ł –ľ–Ķ—ā–ĺ–ī –ł–∑–ł—Ā–ļ–≤–į –≤—Ā–Ķ –Ņ–į–ļ –≥—ä–≤–ļ–į–≤ –Ņ–ĺ–ī—Ö–ĺ–ī –∑–į –∑–į–Ņ–ĺ–ľ–Ĺ—Ź–Ĺ–Ķ –Ĺ–į –ī–į–Ĺ–Ĺ–ł—ā–Ķ, –∑–į –ī–į –ľ–ĺ–∂–Ķ —Ä–ĺ–Ī–ĺ—ā—ä—ā –ī–į –ĺ—Ā—ä–∑–Ĺ–į–Ķ, —á–Ķ –į–ļ–ĺ –Ĺ—Ź–ļ–ĺ–ł –Ņ—Ä–į–≤–ł–Ľ–į –Ī–Ķ–∑–į–Ņ–Ķ–Ľ–į—Ü–ł–ĺ–Ĺ–Ĺ–ĺ –≤–į–∂–į—ā –∑–į –Ķ–ī–Ĺ–į —Ā–ł—ā—É–į—Ü–ł–ł, –Ĺ–Ķ –Ķ –∑–į–ī—ä–Ľ–∂–ł—ā–Ķ–Ľ–Ĺ–ĺ –ī–į –Ķ —ā–į–ļ–į –ł –≤ –ī—Ä—É–≥ –ļ–ĺ–Ĺ—ā–Ķ–ļ—Ā—ā.

–ö–ĺ–ľ–Ī–ł–Ĺ–į—Ü–ł—Ź—ā–į –ĺ—ā —ā–Ķ–∑–ł –Ņ–ĺ–ī—Ö–ĺ–ī–ł –ľ–ĺ–∂–Ķ –ī–į –Ņ–ĺ–∑–≤–ĺ–Ľ–ł –Ĺ–į —Ä–ĺ–Ī–ĺ—ā–į –ī–į –Ņ–ĺ–Ľ—É—á–ł –Ņ—Ä–Ķ–ī—Ā—ā–į–≤–į –∑–į –Ņ—Ä–į–≤–ł–Ľ–į—ā–į –ł –ī–į –ī–Ķ–Ļ—Ā—ā–≤–į —Ā–Ņ–ĺ—Ä–Ķ–ī —ā—Ź—Ö¬†–ł¬†—Ā–ł—ā—É–į—Ü–ł—Ź—ā–į.

–ú–ĺ–≥–į—ā –Ľ–ł –Ĺ—Ź–ļ–ĺ–≥–į —Ä–ĺ–Ī–ĺ—ā–ł—ā–Ķ –ī–į —Ā—ā–į–Ĺ–į—ā –Ņ–ĺ-–ľ–ĺ—Ä–į–Ľ–Ĺ–ł –ĺ—ā —Ö–ĺ—Ä–į—ā–į?

–†–ĺ–Ī–ĺ—ā–ł—ā–Ķ –Ĺ–į–ł—Ā—ā–ł–Ĺ–į –ł–ľ–į—ā –Ņ–ĺ—ā–Ķ–Ĺ—Ü–ł–į–Ľ–į –ī–į –Ī—ä–ī–į—ā –Ņ–ĺ-–Ĺ—Ä–į–≤—Ā—ā–≤–Ķ–Ĺ–ł, –ĺ—ā–ļ–ĺ–Ľ–ļ–ĺ—ā–ĺ —Ā–į–ľ–ł—ā–Ķ —Ö–ĺ—Ä–į.

- –†–ĺ–Ī–ĺ—ā–ł—ā–Ķ, –∑–į —Ä–į–∑–Ľ–ł–ļ–į –ĺ—ā —Ö–ĺ—Ä–į—ā–į, –Ĺ–Ķ —Ā–į –Ķ–≥–ĺ–ł—Ā—ā–ł—á–Ĺ–ł. –ź–ļ–ĺ —Ā–Ķ –ĺ–Ī—É—á–ł –ī–ĺ–Ī—Ä–Ķ, —Ä–ĺ–Ī–ĺ—ā—ä—ā —Č–Ķ –ł–ľ–į –Ņ—Ä–ł–ĺ—Ä–ł—ā–Ķ—ā —á–ĺ–≤–Ķ—ą–ļ–ł—ā–Ķ –ł–Ĺ—ā–Ķ—Ä–Ķ—Ā–ł, –Ī–Ķ–∑ –ī–į —ā—ä—Ä—Ā–ł —Ā–ĺ–Ī—Ā—ā–≤–Ķ–Ĺ–į –Ņ–ĺ–Ľ–∑–į. –†–ĺ–Ī–ĺ—ā—ä—ā –ľ–ĺ–∂–Ķ –ī–į —Ā–Ľ–Ķ–ī–≤–į –Ķ–ī–Ĺ–ĺ–≤—Ä–Ķ–ľ–Ķ–Ĺ–Ĺ–ĺ —Ā–ĺ–Ī—Ā—ā–≤–Ķ–Ĺ–ł—ā–Ķ —Ā–ł —Ü–Ķ–Ľ–ł –ł –ĺ–Ī—Č–Ķ—Ā—ā–≤–Ķ–Ĺ–ł—ā–Ķ –Ĺ–ĺ—Ä–ľ–ł, –Ī–Ķ–∑ –ī–į —Ā–ł –Ņ—Ä–ĺ—ā–ł–≤–ĺ—Ä–Ķ—á–į—ā.

- –†–ĺ–Ī–ĺ—ā–ł—ā–Ķ –Ĺ—Ź–ľ–į—ā –Ķ–ľ–ĺ—Ü–ł–ł –ļ–į—ā–ĺ –≥–Ĺ—Ź–≤, –∑–į–≤–ł—Ā—ā –ł–Ľ–ł —Ā—ā—Ä–į—Ö, –ļ–ĺ–ł—ā–ĺ –ī–į –Ņ–ĺ–≤–Ľ–ł—Ź–≤–į—ā –Ĺ–į –ľ–ĺ—Ä–į–Ľ–Ĺ–ł—ā–Ķ –ł–ľ —Ä–Ķ—ą–Ķ–Ĺ–ł—Ź, –ļ–į–ļ—ā–ĺ —Ā–Ķ —Ā–Ľ—É—á–≤–į –Ņ—Ä–ł —Ö–ĺ—Ä–į—ā–į. –Ě—Ź–ļ–ĺ–ł –ī–ĺ—Ä–ł —Ā–ľ—Ź—ā–į—ā, —á–Ķ —ā–ĺ—á–Ĺ–ĺ—Ā—ā—ā–į –ł –Ņ–ĺ—Ā–Ľ–Ķ–ī–ĺ–≤–į—ā–Ķ–Ľ–Ĺ–ĺ—Ā—ā—ā–į –Ĺ–į –ī–Ķ–Ļ—Ā—ā–≤–ł—Ź—ā–į –Ĺ–į —Ä–ĺ–Ī–ĺ—ā–ł—ā–Ķ –Ņ—Ä–į–≤—Ź—ā –ĺ—ā —ā—Ź—Ö –ĺ—ā–Ľ–ł—á–Ĺ–ł –≤–ĺ–Ļ–Ĺ–ł—Ü–ł, –ļ–ĺ–ł—ā–ĺ –∑–į —Ä–į–∑–Ľ–ł–ļ–į –ĺ—ā —Ö–ĺ—Ä–į—ā–į, –Ĺ–Ķ –Ī–ł—Ö–į –Ņ—Ä–Ķ—Ā—ā—ä–Ņ–ł–Ľ–ł –Ĺ—Ź–ļ–į–ļ–≤–ł –Ĺ–ĺ—Ä–ľ–ł –Ĺ–į –ľ–Ķ–∂–ī—É–Ĺ–į—Ä–ĺ–ī–Ĺ–ĺ—ā–ĺ —Ö—É–ľ–į–Ĺ–ł—ā–į—Ä–Ĺ–ĺ –Ņ—Ä–į–≤–ĺ.

- –†–ĺ–Ī–ĺ—ā–ł—ā–Ķ –≤¬†–Ī–Ľ–ł–∑–ļ–ĺ—ā–ĺ –Ī—ä–ī–Ķ—Č–Ķ —Č–Ķ –ł–ľ–į—ā –ļ–ĺ–Ĺ–ļ—Ä–Ķ—ā–Ĺ–ł —Ä–ĺ–Ľ–ł –ł —Č–Ķ —Ā–Ķ –ł–∑–Ņ–ĺ–Ľ–∑–≤–į—ā –∑–į –ĺ–≥—Ä–į–Ĺ–ł—á–Ķ–Ĺ –ļ—Ä—ä–≥ –ĺ—ā –∑–į–ī–į—á–ł. –Ę–ĺ–≤–į –≤–ĺ–ī–ł –ī–ĺ –∑–Ĺ–į—á–ł—ā–Ķ–Ľ–Ĺ–ĺ –Ĺ–į–ľ–į–Ľ—Ź–≤–į–Ĺ–Ķ –Ĺ–į ¬†–ļ–ĺ–Ľ–ł—á–Ķ—Ā—ā–≤–ĺ—ā–ĺ –Ĺ–į –Ņ—Ä–į–≤–ł–Ľ–į, –Ĺ–į –ļ–ĺ–ł—ā–ĺ —ā—Ä—Ź–Ī–≤–į –ī–į —Ā–Ķ –Ĺ–į—É—á–į—ā, –∑–į—Č–ĺ—ā–ĺ –ł —Ā–ł—ā—É–į—Ü–ł–ł—ā–Ķ, –≤ –ļ–ĺ–ł—ā–ĺ —ā—Ä—Ź–Ī–≤–į –ī–į –≤–∑–ł–ľ–į—ā —Ä–Ķ—ą–Ķ–Ĺ–ł–Ķ —Č–Ķ —Ā–į –ł –Ņ–ĺ-–ľ–į–Ľ–ļ–ĺ. –ź–ļ–ĺ —Ä–ĺ–Ī–ĺ—ā–ł—ā–Ķ —Ā–į –į–ļ—ā–ł–≤–Ĺ–ł —É—á–į—Ā—ā–Ĺ–ł—Ü–ł –≤ —Ā–Ņ–Ķ—Ü–ł—Ą–ł—á–Ĺ–ł —Ā–ĺ—Ü–ł–į–Ľ–Ĺ–ł –ĺ–Ī—Č–Ĺ–ĺ—Ā—ā–ł, —ā–Ķ —Č–Ķ –Ī—ä–ī–į—ā –Ņ—Ä–ĺ–Ķ–ļ—ā–ł—Ä–į–Ĺ–ł –ł –ĺ–Ī—É—á–Ķ–Ĺ–ł –≤ —Ä–į–ľ–ļ–ł—ā–Ķ –Ĺ–į –Ĺ–ĺ—Ä–ľ–ł—ā–Ķ –Ĺ–į —ā–į–∑–ł –ĺ–Ī—Č–Ĺ–ĺ—Ā—ā.

–ó–į–ī–į—á–į—ā–į –∑–į –Ņ—Ä–ĺ–Ķ–ļ—ā–ł—Ä–į–Ĺ–Ķ—ā–ĺ –Ĺ–į —Ä–ĺ–Ī–ĺ—ā–ł, –ļ–ĺ–ł—ā–ĺ –ľ–ĺ–≥–į—ā –ī–į —Ä–į–∑–Ī–Ķ—Ä–į—ā —Ā–ł—ā—É–į—Ü–ł—Ź—ā–į –ł –ī–į –ī–Ķ–Ļ—Ā—ā–≤–į—ā –≤ —Ā—ä–ĺ—ā–≤–Ķ—ā—Ā—ā–≤–ł–Ķ —Ā –ľ–ĺ—Ä–į–Ľ–Ĺ–ł—ā–Ķ –Ĺ–ĺ—Ä–ľ–ł –Ĺ–į —á–ĺ–≤–Ķ–ļ–į, –Ķ —ā—Ä—É–ī–Ĺ–į, –Ĺ–ĺ –Ĺ–Ķ –ł –Ĺ–Ķ–≤—ä–∑–ľ–ĺ–∂–Ĺ–į. –•—É–Ī–į–≤–ĺ –Ķ, —á–Ķ –ĺ–≥—Ä–į–Ĺ–ł—á–Ķ–Ĺ–ł—ā–Ķ –≤—ä–∑–ľ–ĺ–∂–Ĺ–ĺ—Ā—ā–ł—ā–Ķ –Ĺ–į —Ā—ä–≤—Ä–Ķ–ľ–Ķ–Ĺ–Ĺ–ł—ā–Ķ —Ä–ĺ–Ī–ĺ—ā–ł –Ĺ–ł –ī–į–≤–į—ā –≤—Ä–Ķ–ľ–Ķ –ī–į –≥–ł –Ĺ–į—É—á–ł–ľ –Ĺ–į –ľ–ĺ—Ä–į–Ľ –ł –Ķ—ā–ł–ļ–į. –í–Ķ—Ä–ĺ—Ź—ā–Ĺ–ĺ —Č–Ķ –ł–ľ–į –ł –≥—Ä–Ķ—ą–ļ–ł, –Ĺ–ĺ –Ī—ä–ī–Ķ—Č–Ķ—ā–ĺ –Ķ –Ĺ–į —Ā—ä—ā—Ä—É–ī–Ĺ–ł—á–Ķ—Ā—ā–≤–ĺ—ā–ĺ –Ņ–ĺ–ľ–Ķ–∂–ī—É –Ĺ–ł.

–ė–∑—ā–ĺ—á–Ĺ–ł—Ü–ł:

Machine ethics: The robot’s dilemma, Nature, Boer Deng

Robot Ethics,  IEEE Robotics & Automation Society

Beyond Surveillance: Darpa Wants a Thinking Camera, Wred, SPENCER ACKERMAN

Moral Machines, GARY MARCUS

–ě—Č–Ķ –Ņ–ĺ —ā–Ķ–ľ–į—ā–į

–Ę–Ķ—Ö–Ĺ–ĺ–Ľ–ĺ–≥–ł–ł

–ö–į–ļ –Ī–Ķ–∑–Ņ–ł–Ľ–ĺ—ā–Ĺ–ł—ā–Ķ –į–≤—ā–ĺ–ľ–ĺ–Ī–ł–Ľ–ł —Č–Ķ –Ņ—Ä–ĺ–ľ–Ķ–Ĺ—Ź—ā —Ā–≤–Ķ—ā–į (–≤–ł–ī–Ķ–ĺ)

–Ę–Ķ—Ö–Ĺ–ĺ–Ľ–ĺ–≥–ł–ł

5 –≥—Ä–į–ī–į, –≤ –ļ–ĺ–ł—ā–ĺ —Ā–Ķ –ī–≤–ł–∂–į—ā —Ā–į–ľ–ĺ—É–Ņ—Ä–į–≤–Ľ—Ź–Ķ–ľ–ł –į–≤—ā–ĺ–Ī—É—Ā–ł (–≤–ł–ī–Ķ–ĺ)

–Ę–Ķ—Ö–Ĺ–ĺ–Ľ–ĺ–≥–ł–ł

–†–ĺ–Ī–ĺ—ā —Č–Ķ —Ä–į–∑–Ĺ–į—Ā—Ź –Ņ–ĺ–ļ—É–Ņ–ļ–ł—ā–Ķ –Ĺ–į –Ľ–ĺ–Ĺ–ī–ĺ–Ĺ—á–į–Ĺ–ł –ĺ—ā –ī–ĺ–≥–ĺ–ī–ł–Ĺ–į

–ö–ĺ–ľ–Ķ–Ĺ—ā–į—Ä–ł

–ú–ĺ–Ľ—Ź, —Ä–Ķ–≥–ł—Ā—ā—Ä–ł—Ä–į–Ļ—ā–Ķ —Ā–Ķ –ĺ—ā T–£–ö!

–ź–ļ–ĺ –≤–Ķ—á–Ķ –ł–ľ–į—ā–Ķ —Ä–Ķ–≥–ł—Ā—ā—Ä–į—Ü–ł—Ź, –Ĺ–į—ā–ł—Ā–Ĺ–Ķ—ā–Ķ –Ę–£–ö!

09.12 2015 –≤ 20:56

–ü–ĺ—Ā–Ľ–Ķ–ī–Ĺ–ł –ļ–ĺ–ľ–Ķ–Ĺ—ā–į—Ä–ł

4I4ATA

–Ě–ĺ–≤, —Ā–ļ—Ä–ł—ā –ī–ĺ—Ā–Ķ–≥–į –≤—Ö–ĺ–ī –≤ –Ņ–ł—Ä–į–ľ–ł–ī–į—ā–į –Ĺ–į –ú–ł–ļ–Ķ—Ä–ł–Ĺ –Ķ –ĺ—ā–ļ—Ä–ł—ā –Ņ–ĺ –į–Ĺ–ĺ–ľ–į–Ľ–ł–ł –Ņ—Ä–ł —Ā–ļ–į–Ĺ–ł—Ä–į–Ĺ–Ķ

YKoshev

–ü—Ä–Ķ—Ā—ā–ł–∂–Ĺ–į –Ĺ–į–≥—Ä–į–ī–į –ĺ—ā –Ď–ź–Ě —Ā–Ņ–Ķ—á–Ķ–Ľ–ł –≥–Ľ–į–≤–Ĺ–ł—Ź—ā —Ä–Ķ–ī–į–ļ—ā–ĺ—Ä –Ĺ–į –Ě–į—É–ļ–įOFFNews

Johnny B Goode

–ü—Ä–Ķ—Ā—ā–ł–∂–Ĺ–į –Ĺ–į–≥—Ä–į–ī–į –ĺ—ā –Ď–ź–Ě —Ā–Ņ–Ķ—á–Ķ–Ľ–ł –≥–Ľ–į–≤–Ĺ–ł—Ź—ā —Ä–Ķ–ī–į–ļ—ā–ĺ—Ä –Ĺ–į –Ě–į—É–ļ–įOFFNews

Gunteer

–ü—Ä–Ķ—Ā—ā–ł–∂–Ĺ–į –Ĺ–į–≥—Ä–į–ī–į –ĺ—ā –Ď–ź–Ě —Ā–Ņ–Ķ—á–Ķ–Ľ–ł –≥–Ľ–į–≤–Ĺ–ł—Ź—ā —Ä–Ķ–ī–į–ļ—ā–ĺ—Ä –Ĺ–į –Ě–į—É–ļ–įOFFNews

–•—Ä–ł—Ā—ā–ł—Ź–Ĺ–ł–Ĺ

–Ę–ĺ–≤–į –Ķ –ļ—Ä–į–Ľ—Ź—ā –Ĺ–į —ā–ł–ļ–≤–ł—ā–Ķ: –Ę–ł–ļ–≤–į—ā–į –ľ—É —ā–Ķ–∂–ł –Ĺ–į–ī –Ķ–ī–ł–Ĺ –Ķ–ī–ł–Ĺ —ā–ĺ–Ĺ