Напоследък доста се говори за изкуствения интелект. Как щял евентуално да ни замени, да трансформира фундаментално индустрията и работните ни места или в другата, по-абстрактна крайност, как щял да затрие неминуемо някой ден човечеството, превръщайки ни просто в спомен или поданици на един нов свят, който ще се управлява от машинните ни господари.

Отвъд всичко това обаче във вярванията за изкуствения интелект – какво е, какво може да прави и т.н., съществуват някои основни проблеми и ограничения, които редовно се пренебрегват, но всъщност правят вероятността за появата на истински автономни машини някой ден или мокри технократски мечти като сливането на човека и машината доста съмнителни.

Тук ще се опитаме да разгледаме именно част от тези често премълчавани трудности – и защо нещата са доста по-зле, отколкото очакваме.

Прах и сенки

Често пъти в разговорен план “изкуственият интелект” се бърка с неща, които не са съвсем това. А относително скромни научни успехи се преувеличават до грандиозни пропорции, граничещи с научната фантастика.

Както обича да напомня професорът по когнитивна наука Гари Маркъс (но и не само), “разкритията”, които от време на време изтичат по медиите, как еди кой си бил постигнал някакъв особено мощен “изкуствен интелект” в лабораторията си, как “технологията била в пелените си, но скоро ще видим ние”, тревогите на Сам Алтман за “спасяването на човечеството от AI” или т.н... са по-скоро прах в очите и хитър пиар трик. Nonsense on the stilts.

Това не е случайност. Залогът на съвременната AI индустрия е буквално в стотици милиарди, разходите са огромни, а потенциалните печалби още повече – и поглъща огромни количества енергия, които е вероятно да навредят на околната среда.

На фона на тези световни тенденции, дори в далеч по-скромните български условия, Институтът за изкуствен интелект и компютърна наука към СУ изисква поне едни 100 милиона лева годишно, за да функционира пълноценно. Обстоятелство, използвано като основна тема в предизборните кампании на двама от кандидатите за ректор миналата година.

Звучи със сигурност втрещяващо да се каже, че “изкуственият интелект вече рисува картини или пише есета”, но е хубаво на първо време да се има предвид, че онова, което непрекъснато се реферира масово като ИИ, не е съвсем ИИ, а са предимно статистически модели. Не космическия кораб, а просто някаква важна част от него.

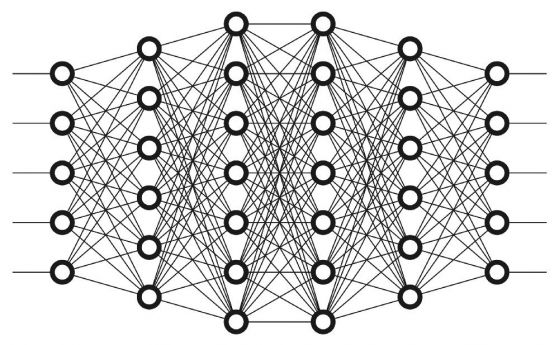

Ако вземем конкретен пример – масово използваният ChatGPT, да речем, се основава на невронна мрежа тип трансформатор. Той е статистически модел, който всъщност заучава взаимовръзките между различните думи и предсказва в процеса на обучението си кои думи е по-подходящо да вървят с други думи (т.нар. next token prediction). Нещо, което напомня привидно на изключително по-сложна версия на autocomplete-а в телефона.

В своя блог Алонсо Силва дава хубава илюстрация на това с любимата ми песен.

Повтарянето на тази проста процедура (“предсказване на следващия тоукън”) е в състояние да доведе до възможност за генерирането на цели изречения, които привидно имат смисъл, но са просто резултат от следване на сложни статистически взаимовръзки. И използването на човешки оценители от плът и кръв за “коригиране” на глупостите, когато неизбежно възникнат в предсказанията при изграждането на модела. Както се изразява Йоханес Йегер в едно свое есе (което горещо препоръчвам): “парейдолия на стероиди” .

Бихте ли дали на autocomplete-a на телефона си да решава вместо вас?

“Още е в пелени, но ще видите вие”

Непрекъснато слушаме фантастични приказки за бъдещето, но истината е, че примерите за изпатилите от безкритичната вяра в мита за изкуствения интелект стават все повече. Ето един, надявам се, не твърде дълъг за четене списък от сравнително скорошни случки, загатващи за онова, което наистина се задава на хоризонта.

Уволняването на купища служители и ентусиазираното въвеждане на “AI журналисти” в медии като CNET или Sports Illustrated доведе до вълна от зле написани текстове, грешки и откровени измислици, което наложи пренаписването им от човешки редактори. Някои американски адвокати загубиха работата си и получиха тежки обвинения, след като използваха ChatGPT, за да спестят време, представяйки текстове, пълни с фалшива информация, в съда. Използването на страховити “дигитални актьори” от Дисни отнесе купища подигравки в социалните мрежи, разваляйки иначе хубави филми и творчески замисли.

Макар и като цяло катастрофите със самоуправляващи се коли да са по-редки, отколкото с човешки шофьор, самоуправляващите се коли доведоха до редица зловещи инциденти и смъртни случаи в последно време – дори в предварително ограничени и внимателно регулирани за целта градски зони. Понякога спират посред празни улици или отказват да тръгнат. В един нашумял скандал от миналата година самоуправляваща се кола спряла до бутната жена на пътя, както се очаква. Тъй като обаче ситуацията, в която жената лежала на пътя, липсвала в разпределението на данните, с които е обучен моделът, колата внезапно решава да мине през тялото й и започва да я влачи по пътя.

Новите, обновени версии на ChatGPT започнаха да демонстрират ефекти на деградация с времето и да бъркат простички неща (https://arxiv.org/pdf/2307.09009.pdf), които някога са отговаряли правилно (дори с абонамент). Що се отнася до творческия бранш, когато не рисуват по 7 пръста на ръка, генераторите на картини се оказаха склонни да възпроизвеждат случайно, но с абсолютна точност, конкретни сцени от художествени произведения, филми и игри според серия от уличаващи експерименти на Гари Маркъс и Райд Саудън – което ощетява не само художниците, но и създава неприятни рискове за потребителите на услугата, искащи да ги използват за някакви собствени цели.

chatGPT is becoming borderline unusable

— Sully (@SullyOmarr) January 23, 2024

we have it for our team, but its coding ability has significantly gotten worse lately

i even made GPTs for my team, using every prompting trick in the book and it still doesn't want to code

anyone else experiencing this?

Нещо, с което мога да се съглася от личния си опит – drive-thru чатботовете на Макдоналдс в чужбина доведоха до купища неадекватни интеракции и изнервени клиенти (макар и вероятно да намаляват значително разходите на ресторантите). Ситуация, която все пак се пооправи с по-честата намеса на човешки служители, когато нещата се объркат непреодолимо.

@that_usa_guy Trying the McDonald's AI drive thru....Again @McDonald’s Corporate #fail ♬ original sound - Dal JustDal

И в крайна сметка действително проблемът с дезинформацията и фалшивите новини става все по-зле. Според резултатите на учени от Amazon Web Services (https://arxiv.org/pdf/2401.05749.pdf) поне 58 процента от интернет пространството е вече пълно с нискокачествено съдържание, генерирано и препревеждано с модели – навярно с целта да се постигне бърза печалба. Всъщност претрупването с изкуствено генерирано съдържание, произведено от различни генеративни модели, е вероятно да доведе до тъй нареченото “моделово автофагийно разстройство” (model autophagy disorder) – обучаването на един модел с неща от интернет, произведени от друг модел, води до тежка деградация в качеството на модела. Ако не се използва някакъв начин да се отделя качествено човешкото съдържание от изкуственото, това би довело до много лоши последици за моделите и потребителите им. Вече води де…

Мъдростта на древните хора

Вярно е, разбира се, в противовес на такива видими с просто око факти, че някакви експерименти бяха показали преди време как големи езикови модели като ChatGPT, Google Bard и т.н. имат близко до човешкото представяне на психологически и образователни тестове https://tech.offnews.bg/tehnologii/openai-predstavi-novia-model-gpt-4-kojto-osven-tekstovete-razbira-i-i-20337.html – а дори мистериозната поява на напълно неочаквани умения, в които някои назначени от корпорациите изследователи “привидяха” искрата на съзнанието или…внезапна емерджентност. https://www.quantamagazine.org/the-unpredictable-abilities-emerging-from-large-ai-models-20230316/

Може би пишейки тези редове, е добре все пак да се запитам дали не cherry-pick-вам удобните за мен анекдоти, спестявайки си болезнената истина, че нищо вече няма да бъде същото? Нима не е вярно, че наскоро учени, свързани с Google, също така публикуваха цяло изследване https://www.nature.com/articles/s41586-023-06924-6 върху FunSearch, според което “изкуственият интелект” е разрешил “фундаментален нерешен проблем” от областта на чистата математика – отвъд възможностите на най-добрите човешки математици?

Буквално в Nature го съобщиха!

Със сигурност на пръв (и втори) поглед това са впечатляващи резултати, но всъщност резултатите от тези революционни експерименти бяха оспорени и обширно разкритикувани от редица учени и други изследвания.

В свой експеримент учени от Станфорд например показаха, че „емерджентните способности на големите езикови модели вероятно са творения на изборите, направени от изследователя, а не същинско свойство на семейството модели за конкретната задача.“ Или казано с малко повече подробности, съществуват добри индикации, че те са илюзии, дължащи се на самите методи и метрики, предпочетени от учените, не някакво разтърсващо откритие и реално явление.

По отношение на мистериозните почти човешки способности на моделите същевременно се появиха индикации, че при изграждането им е станало тъй нареченото “замърсяване на обучителната извадка” (което е сериозен проблем при изграждането на статистически модели по принцип). Това значи тестване на някакъв модел върху вече видяни данни, което дава фалшиво високи резултати. Все едно да надникнеш зад завесата и след това да “предскажеш” какво има там. Съществуват примери за някои по-обстойни проучвания всъщност, които установяват, че на фона на случаи от действителния свят големите езикови проблеми се провалят зрелищно. Екип от компютърни учени установяват, че GPT-4 и други модели се справят с едва между 1 и 4 процента от реални проблеми / въпроси от областта на софтуерното инженерство, взети от сайта на GitHub. За целите на експериментите те дават на моделите код и описание на всеки проблем, което да използва, за да редактира кода и да го разреши.

Що се отнася до великото математическо доказателство, нещата не са съвсем така, както се съобщават в научните сайтове. Според анализ на професора по компютърна наука Ърнест Дейвис (https://cs.nyu.edu/~davise/papers/FunSearch.pdf) анонсът за разрешаването на някакъв фундаментален математически проблем от FunSearch е доста преувеличен и граничи с фалшива новина, докато в действителност става дума за група математици, които са се осланяли на уменията си по програмиране и пренастройване, за да им свърши работа моделът в някакви скромни граници – и то за относително стандартен математически проблем. Всъщност Дейвис стига до заключението, че творението на Гугъл се представя значително по-зле от други отдавна известни методи и подходи от областта на AI.

Не на последно място, в мощен удар по корпоративния PR, експеримент на Берглунд и колеги от 2023 г. демонстрира, че Големите езикови модели се провалят систематично в заучаването на симетрични отношения между обектите. Ако обучиш модела си, че “Вашингтон е първият американски президент” (A->B), почти сигурно моделът не научава автоматично, че “Първият американски президент е Вашингтон” (B->A). Всяка подобна двойка изисква отделни примери – и липсата им гарантира сигурен провал.

Така че един по-приземен поглед ще ни разкрие по-скоро, че ако има нещо закономерно в настоящите масово използвани модели за ”изкуствен интелект”, това е всъщност техният провал и съмнителната им надеждност да се справят с фактите. Независимо колко упорито се напъват пиарите или с колко голямо количество данни бъдат наблъскани моделите.

Най-интересното от цялата работа е, че фрапиращите дефицити на голяма част от днешните невронни мрежи са “предсказани” още от ранните философи и когнитивни учени / психолози, работещи в областта на математическото моделиране на мозъка. Липсата на способност за обобщаване на случващото се от конекционистичните модели по систематичен начин в различните ситуации (за разлика от символните модели) е разкритикувана напоително преди буквално 50 години, в една класическа статия от Фодор и Пилишин. Който му е интересно, може да се запознае подробно с тяхната перспектива тук.

Така че няма такова нещо като “халюцинация”; има само грешно предсказание, защото много от моделите не боравят с информацията по някакъв смислен или систематичен начин, а използват повърхностни признаци, които са чужди като логика не само на човек, но и на някои от по-примитивните живи организми.

По думите на професора по AI & когнитивна наука Гари Маркъс, който не спира да “хейти” в блога си.

"В математиката, когато човек има някакво предположение, е достатъчен прост контрапример. Ако кажа, че всички нечетни числа са прости, 1, 3, 5 и 7 може да подкрепят идеята ми, но при 9 играта свършва. В дискусията за невронните мрежи хората често се впечатляват от успехите и обръщат твърде малко внимание на това, което неуспехите се опитват да им кажат. Тази грешка в симетрията е толкова брутална и постоянна, че продължава с десетилетия. Тук има толкова ясен и рязък провал в разсъжденията, че ме изкушава просто да спра да мисля и пиша за големите езикови модели като цяло. Ако след обучение върху почти целия интернет знаете, че Том е син на Мери Лий, но не можете да разберете, без специално подсказване, че следователно Мери Лий е майката на Том, нямате просто работа да управлявате софтуера на света."

Все пак има някои вълнуващи пробиви, на които попаднах наскоро – като MLC (Meta-learning for compositionality) на професора по психология Брендън Лейк, които обещават да подобрят значително проблема с композиционното учене, описан в класическата статия на Фодор и Пилшин. При все това Лейк в статията си сам обръща внимание, че методът му все още има сериозни ограничения:

"Въпреки успехите си, MLC не решава всяко предизвикателство, отправено от Фодор и Пилишин. Той не се справя автоматично с непрактикувани форми на обобщение или концепции извън meta-learning разпределението, намалявайки обсега на изцяло новите структури, които е в състояние да обработи правилно. Нещо повече, MLC не успява да обобщи нюанси в индуктивните уклони, за които не е оптимизиран… мета-обучението само по себе си няма да позволи на стандартна мрежа да обобщава епизоди, които са извън разпределението по отношение на представените по време на мета-обучението."

В този смисъл предизвикателството на Фодор и Пилишин – да се постигне някакво систематично познание чрез невронните мрежи на конекционизма, обхващащо невиждани и нови контексти (както е при хората и хлебарките, които лесно се ориентират с оскъдна информация, в разнообразни условия и прехвърлят наученото с лекота към тях), остава все още като цяло неразрешено. Може би има някаква надежда и с разработването на т.нар. невро-символични мрежи, но засега нещата са зле и невро-символичните системи са приложими в относително прости контексти. (https://arxiv.org/pdf/2401.01040.pdf)

Тук дори не коментирахме отдавна известния в проучванията за невронните мрежи проблем за катастрофалното забравяне, което е вероятно да настъпи при продължителното обучаване на някои архитектури с нови данни. Когато например някаква невронна мрежа тип MLP (перцептрон с множество слоеве) или Голям езиков модел бъде обучен върху нови задачи, това е вероятно да влоши представянето му при по-рано научените задачи. https://arxiv.org/abs/2308.08747

Грешни предсказания

Отвъд всичко това си струва да се оцени отдавна известното, съвсем странично обстоятелство, че дори да бъдат обучени или тествани както трябва – всички статистически модели като цяло се разпадат с времето (някои по-плавно, други по-рязко и непредсказуемо), защото просто светът непрекъснато се променя и защото всички негови елементи си взаимодействат по сложни начини. Това не е кой знае колко фундаментална пречка, колкото практически проблем пред използването на моделите от потребителите им.

Разбира се, редовно виждам в собственото си поле как предварително валидирани модели от структурни уравнения се разпадат при подаването на невиждани данни или независими извадки от хора, а корелацията между истинските стойности и предсказанията на модела (която отвъд линейните регресии не е съвсем адекватна като метрика, но при ограничени случаи върши някаква работа) пада под критични нива на взаимна информация.

Ако си позволим едно леко лирично отклонение, тук се съдържа реално една от причините било IQ тестовете (или други подобни), да се провалят болезнено с предиктивната си валидност в образованието, работата или пърформънса в някакви интелектуални начинания (дори при налагане на корекция за грешката на измерване в уравненията; повече по този въпрос в статията ми “Нищо като нещо”). Не казвайте това на симпатичните люде от МЕНСА или на онзи тип HR-и, които получават тлъсти бонуси, за да мерят интелектуалния потенциал на служителите си и да ги класифицират по стандартизирани тестове.

Но да не се отклонявам прекомерно … Както бях тръгнал да казвам…

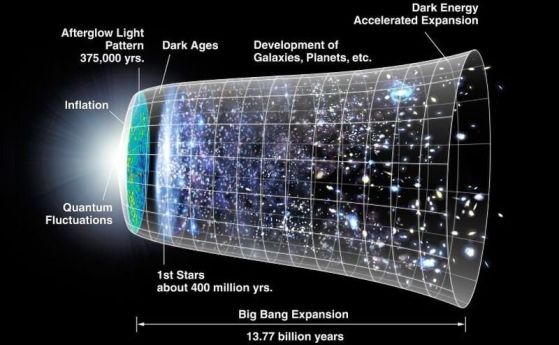

Идеята за тъй наречения “model drift” е отдавна известна, но това се онагледява елегантно от серия скорошни опити на Вела и колеги, публикувани в Nature. Те сравняват грешката на различни регресионни модели с времето – линейни регресии, рандъм форъст регресори, невронни мрежи и т.н., като използват данни от редица области (финанси, времето, здравеопазване и т.н.).

Адаптирано от Vela et al., 2022

Адаптирано от Vela et al., 2022

По-конкретно става въпрос за усреднената разлика между истинската стойност и предсказанието на модела: Y(истина) – Y(модел), като идеята е двете да не се раздалечават много. Съответно Y(истина) – Y(модел) в началото се сравнява с Y(истина) – Y(модел) с течение на времето. С изминаването на времето разликата между истината и предсказанието на модела при подаването на нови данни става наистина зле, като в някои случаи невронните мрежи (перцептрони с множество слоеве) деградират в пъти по-зле от обикновената регресия.

Както древните мъдреци казват, всичко тече, всичко се променя.

Мнението на редакцията на НаукаOFFNews не съвпада непременно с мнението на автора.

Още по темата

Технологии

Изкуствен интелект открива месопотамски археологически обекти в сателитни снимки

Технологии

Краде ли изкуственият интелект на Lensa от човешкото изкуство? Експерт обяснява противоречията

Медицина

Изкуствен интелект е създал протеини, убиващи бактерии

Коментари

Моля, регистрирайте се от TУК!

Ако вече имате регистрация, натиснете ТУК!

Няма коментари към тази новина !

Последни коментари

dolivo

Земната ябълка: стара култура за новите климатични времена

dolivo

Земята потъмнява. Какво означава тази тревожна климатична тенденция за бъдещето?

Nikor

На 30 септември 1928 е открит пеницилинът

Прост Човек

Ново обяснение за гигантските експлодиращи кратери в Сибир